传媒教育网

标题: 人工智能与新闻业案例集锦 [打印本页]

作者: 刘海明 时间: 2018-12-17 23:15

标题: 人工智能与新闻业案例集锦

当代社会,技术支撑的这个世界变化有点快,算法、人工智能等技术让人眼花缭乱,新闻业也搭上了这班快车。我们不得不开始收集这方面的信息,以免被时代很快淘汰。

作者: 刘海明 时间: 2018-12-17 23:17

【案例】

你所未知的人工智能应用领域理查德·格雷(Richard Gray)

· 2017年9月 27日

· 分享平台 微博

· 分享平台 人人网

· 分享平台 电邮

· 分享file:///C:/Users/35242/AppData/Local/Temp/msohtmlclip1/01/clip_image002.jpg

Image copyright[size=0.875]GETTY IMAGES

对有些人来说,人工智能和机器人技术的普及对我们的隐私、工作甚至人身安全构成了威胁,因为越来越多的任务不是由人脑,而是由“硅脑”来执行。

<iframe frameborder="0" src="https://tpc.googlesyndication.com/safeframe/1-0-31/html/container.html" id="google_ads_iframe_/4817/bbcworldservice.live.site.ukchinasimp/ukchinasimp_vertfut_content_1" title="3rd party ad content" name="1-0-31;9136;[img=1,1][/img]

[img=1,1][/img]

[img][/img]{"uid":1,"hostPeerName":"https://www.bbc.com","initialGeometry":"{\"windowCoords_t\":0,\"windowCoords_r\":1093,\"windowCoords_b\":575,\"windowCoords_l\":0,\"frameCoords_t\":0,\"frameCoords_r\":0,\"frameCoords_b\":0,\"frameCoords_l\":0,\"styleZIndex\":\"auto\",\"allowedExpansion_t\":0,\"allowedExpansion_r\":0,\"allowedExpansion_b\":0,\"allowedExpansion_l\":0,\"xInView\":0,\"yInView\":0}","permissions":"{\"expandByOverlay\":false,\"expandByPush\":false,\"readCookie\":false,\"writeCookie\":false}","metadata":"{\"shared\":{\"sf_ver\":\"1-0-31\",\"ck_on\":1,\"flash_ver\":\"0\"}}","reportCreativeGeometry":false,"isDifferentSourceWindow":false,"goog_safeframe_hlt":{},"encryptionMode":null}" scrolling="no" marginwidth="0" marginheight="0" width="300" height="600" data-is-safeframe="true" sandbox="allow-forms allow-pointer-lock allow-popups allow-popups-to-escape-sandbox allow-same-origin allow-scripts allow-top-navigation-by-user-activation" data-google-container-id="2" tabindex="-1" style="color: inherit; font-style: inherit; font-variant: inherit; font-stretch: inherit; font-weight: inherit; letter-spacing: inherit; line-height: inherit; border-width: 0px; font-family: inherit; vertical-align: bottom;">然而,即便是最直言不讳的批评者,也不得不承认人工智能(AI)和自动化系统为人类带来的诸多潜在好处。作为BBC"FutureNow"专栏大挑战系列(GrandChallenges)的一部分,一组专家为我们详细描述了随着我们所使用的机器变得越来越智能,我们周围的世界正在如何发生变化的图景。 今天的"大构想"(GrandIdeas)系列中,BBC"FutureNow"专栏将对已经开始应用于解决世界上最棘手、最危险的一些问题的尖端AI和自动化技术进行了盘点,这些问题包括了疾病防治到应对暴力。

卡内基梅隆大学机器人教授金出武雄(TakeoKanade)说:"我们不应该把 AI 视为与人类竞争的东西,而应该看作是可以增强我们自身能力的东西。"这是因为 AI 不仅能做好单调乏味的工作,还能够识别出模式,这种能力甚至远远超过了人类。

它可能会在21 世纪帮助保护我们的安全。

防治传染病对于全球数十亿人来说,在耳边嗡嗡作响的蚊子不仅会叮咬人们带来令人恼怒的疼或痒,它们还可能带来疾病甚至致命。特别是已经从非洲传播到几乎所有热带和亚热带地区的埃及伊蚊(Aedesaegypti),它们携带登革热(Dengue fever)、黄热病、寨卡(Zika)以及基孔肯雅热(chikungunya,一种导致严重关节痛的病毒)等病毒。在全球 128 个国家和地区,每年仅登革热就会感染 3.9 亿人。

来自多米尼加共和国的计算机工程师雷尼尔·马洛尔(Rainier Mallol)说:"这些蚊子就像小恶魔。"多米尼加共和国是寨卡病毒爆发热点地区。与来自马来西亚(另一个热点)的医学博士达西·拉贾(Dhesi Raja)一起,马洛尔两人开发出一套 AI 算法,能够预测疫情最有可能发生的地方。

file:///C:/Users/35242/AppData/Local/Temp/msohtmlclip1/01/clip_image004.jpg

Image copyright[size=0.875]MICROSOFTImage caption微软的 Project Premonition 项目使用无人机寻找寨卡病毒爆发的热点地区,然后捕捉它们以寻找病原体(图片来源:MicrioSoft)

他们的医学流行病学(Aime)AI 系统可以将所有当地医院新报告的登革热病例出现的时间和地点与包括风向、湿度、温度、人口密度、住房类型等在内的274 个可变因素结合起来。"这些因素都是确定蚊子如何传播的因素," 马洛尔解释道。

到目前为止,在马来西亚和巴西的试点表明,这套系统可以提前三个月准确预测疫情爆发,准确率达到88% 左右。此外,该系统还可以帮助查明疫情中心及其400 米范围内的情况,从而使公共卫生官员能够及早利用杀虫剂进行干预,以防蚊虫对当地居民进行叮咬。

Aime 系统也被用于帮助预测寨卡和基孔肯亚热病毒疫情爆发。大型科技公司也在追求自己的宏伟构想:例如,微软的Project Premonition 项目使用无人机定位蚊子的热点地区,并利用机器人二氧化碳和光捕捉器来收集蚊子样本,包括蚊子以及它们咬过的动物的DNA,然后通过机器学习算法进行分析,从而找到病原体。这些算法能够从大量的数据中识别出模式,而且会变得越来越精确和强大。

应对枪械暴力去年,美国有15,000 人死于枪械暴力,美国也是发达国家中枪械暴力发生率最高的国家。为了解决持续不断的枪击和枪械犯罪问题,许多城市正在试图通过科技寻找解决办法。

file:///C:/Users/35242/AppData/Local/Temp/msohtmlclip1/01/clip_image006.jpg

Image copyright[size=0.875]SHOTSPOTTERImage caption人工智能可以追踪枪声,并帮助急救人员和执法人员在大规模枪击扩散之前予以阻止(图片来源:ShotSpotter)

有一种自动化系统可以用传感器阵列监听枪声,然后精确定位枪声所在的位置,并在45 秒内向相关机构发出警报。这种名为ShotSpotter 系统需要配备大量声音传感器以探测枪械独特的声响,利用其到达每个传感器的时间,通过算法来定位枪击位置,误差在25米之内。

机器学习技术被用来确定声音是否为枪击声,并计算出它们的数量,以帮助警方确定他们要对付的是独行枪手还是有多名行凶者,以及他们是否在使用自动武器。

目前有90 个城市(多在美国,部分在南非和南美)正在使用ShotSpotter 系统。美国 9 所大学校园也部署了较小的 ShotSpotter 系统,以应对最近频发的校园枪击事件。而且美国特勤局已将其安装在白宫内。

但 ShotSpotter公司首席执行官拉尔夫·克拉克(RalphClark)认为,该系统未来的用途不仅仅是简单地应对突发事件。

他表示:"我们迫切希望看到,我们的数据如何能够提供更多的预警信息。机器学习可以把它与天气、交通数据、财产犯罪数据结合起来,从而向巡逻警察更准确地通报消息。"

预防饥荒全世界目前大约有8 亿人依靠木薯根作为主要碳水化合物(为人体提供热能的主要营养素)的来源。这种淀粉类蔬菜与山药相似,经常被人像土豆那样食用,但也可以磨成粉做面包和蛋糕。它能在其他农作物没法生长的地方种植,这使它成为世界上第六大粮食作物。但是这种木本灌木极易受到疾病和害虫的侵害,可以让整片田地都颗粒无收。

位于乌干达坎帕拉(Kampala)马凯雷雷大学(Makerere University)的研究人员与植物病专家合作开发了一套旨在打击木薯疾病的自动化系统。Mcrops项目允许当地农民使用便宜的智能手机拍摄植物,并使用经过训练的计算机视觉来发现造成木薯作物损害的四种主要疾病的迹象。

计算机技术研究员欧内斯特·姆贝泽(Ernest Mwebaze)是这个项目的带头人,他解释说:"这些疾病真的很难识别,需要采取不同的行动根治。我们正在为农民提供'口袋中的专家',以便让他们知道自己是否需要为作物喷药,或者完全毁掉这批作物以便种植其他作物。"

该系统诊断木薯疾病的准确率目前高达88%。以前,农民必须打电话给政府雇佣的专家来他们的农场查明疾病,这可能需要几天甚至几周的时间,而虫害在此期间可能已经大范围扩散。

MCrops 还利用上传到网上的图片来寻找疾病暴发的模式,这可以让官员们阻止可能导致饥荒的流行病。姆贝泽和他的同事们希望利用这项技术来研究香蕉疾病,并开发自动检测其他作物害虫的系统。

抗击癌症和失明file:///C:/Users/35242/AppData/Local/Temp/msohtmlclip1/01/clip_image008.jpg

Image copyright[size=0.875]DEEPMINDImage caption谷歌 DeepMind 可以通过利用机器学习识别病人人体组织内的健康区域来帮助医生提供癌症治疗方案(图片来源:DeepMind)

全世界每年有 880 万人死于癌症,另有1400 万人被诊断出患有某种癌症。尽早发现癌症能够极大地提高患者的生存机会,并降低复发的风险。筛查是早期发现癌症的关键方法之一,但通过扫描和其他方法检测结果费时费力。

不过,谷歌母公司Alphabet 旗下 AI 子公司 DeepMind 和 IBM 都在应用自己的AI 技术来解决这个问题。DeepMind 与伦敦大学学院医院的英国国家卫生署(NationalHealth Service)医生合作,通过识别头部和颈部肿瘤中的健康组织区域,来训练其AI 帮助制定治疗癌症的方法。此外,该公司还与伦敦Moorfields 眼科医院合作,在眼部扫描中识别失明的早期迹象。

DeepMind Health 的临床主管多米尼克·金(DominicKing)说:"我们的算法能够在扫描中解释视觉信息。这个系统学会如何识别潜在的问题,以及如何向临床医生推荐正确的行动。现在我们对结果发表评论还为时过早,但早期的迹象非常令人鼓舞。"

金指出,通过筛选扫描图像,并优先考虑那些临床医生最迫切需要的信息,AI技术可以帮助医生更快地识别和判定病例。

IBM 最近宣布,WatsonAI 可以分析图像,并评估病人的诊断书,从而准确地识别出肿瘤病例,准确率高达96%。世界各地 55 家医院的医生正在对该系统进行测试,以帮助诊断乳腺癌、肺癌、结肠癌、宫颈癌、卵巢癌、胃癌以及前列腺癌。

控制电力应用目前关于气候变化是否导致了美国历史上两场连续灾难性飓风的争论不断升温,那么我们如何才能最大限度地利用清洁、可再生能源来防止对气候模式造成进一步的负面影响?

file:///C:/Users/35242/AppData/Local/Temp/msohtmlclip1/01/clip_image010.jpg

Image copyright[size=0.875]GETTY IMAGESImage captionAI可以实时监控能源需求和生产-从而帮助我们更明智地使用能源、遏制污染以及减少有害气体的排放(图片来源:Getty Images)

世界各地的人们越来越依赖可再生能源来应对气候变化和化石燃料造成的污染,而平衡电力供应的任务变得越来越艰难。智能电表(如可自动记录使用情况的数字能源监视器)的普及,也提供了比以往任何时候都更多的数据,用来说明消费者使用能源的方式和时间。仅欧盟就计划到2020 年在家庭中安装 5 亿个智能电表。

爱丁堡赫里瓦特大学(HeriotWatt University)智能系统助理教授瓦伦丁·罗布(Valentin Robu)表示:"对人类操作者来说,管理所有这些事情是不可能的,尤其考虑到这些事情要求的反应时间通常只有几秒钟。"罗布一直在与英国的初创公司 Upside Energy 合作,开发管理电网的新方法。

他们正在开发机器学习算法,以实时监控能源生产和需求。这样做有什么意义?在平峰时间,能源可以储存起来,然后在高峰的时候释放。随着人们家里的电动汽车和电池越来越普及,这项技术可以利用这些设备储存能源,并消除可再生电力供应不稳定的问题。

罗布还表示,AI可以在更基础的层面上使用,以帮助减少这些设备对电网的需求。例如,电冰箱可以通过AI 远程控制,只有在电网需求较低的时候它们才会开启制冷功能。

https://www.bbc.com/ukchina/simp/vert-fut-41415842

作者: 刘海明 时间: 2018-12-17 23:19

【案例】

人工智能:机器人的科幻版vs现实版

图片版权THINKSTOCKImage caption[size=0.75]机器人越来越像真人,人工智能也越来越逼近甚至超越人类智能。AI时代已经到来?

图片版权THINKSTOCKImage caption[size=0.75]机器人越来越像真人,人工智能也越来越逼近甚至超越人类智能。AI时代已经到来?人类发明创造了机器人,机器人进化到智能超过自己的创造者,不甘屈居次等地位,遂起来反叛,人和机器大战,雷鸣电闪,血肉横飞,最后地球仍属于人类。好莱坞早就讲过这个故事,还有不同版本。

<iframe frameborder="0" src="https://tpc.googlesyndication.com/safeframe/1-0-31/html/container.html" id="google_ads_iframe_/4817/bbcworldservice.live.site.zhongwensimp/zhongwensimp_science_content_1" title="3rd party ad content" name="1-0-31;9424;[img=1,1][/img]

[img][/img]{"uid":1,"hostPeerName":"https://www.bbc.com","initialGeometry":"{\"windowCoords_t\":0,\"windowCoords_r\":1093,\"windowCoords_b\":575,\"windowCoords_l\":0,\"frameCoords_t\":877.8181818181819,\"frameCoords_r\":0,\"frameCoords_b\":877.8181818181819,\"frameCoords_l\":0,\"styleZIndex\":\"auto\",\"allowedExpansion_t\":0,\"allowedExpansion_r\":0,\"allowedExpansion_b\":0,\"allowedExpansion_l\":0,\"xInView\":0,\"yInView\":0}","permissions":"{\"expandByOverlay\":false,\"expandByPush\":false,\"readCookie\":false,\"writeCookie\":false}","metadata":"{\"shared\":{\"sf_ver\":\"1-0-31\",\"ck_on\":1,\"flash_ver\":\"0\"}}","reportCreativeGeometry":false,"isDifferentSourceWindow":false,"goog_safeframe_hlt":{},"encryptionMode":null}" scrolling="no" marginwidth="0" marginheight="0" width="300" height="600" data-is-safeframe="true" sandbox="allow-forms allow-pointer-lock allow-popups allow-popups-to-escape-sandbox allow-same-origin allow-scripts allow-top-navigation-by-user-activation" data-google-container-id="2" tabindex="-1" style="border-width: 0px; border-style: initial; color: inherit; font-style: inherit; font-variant: inherit; font-stretch: inherit; font-family: inherit; font-weight: inherit; letter-spacing: inherit; line-height: inherit; vertical-align: bottom;">

但是,说到人工智能(Artificial intelligence, AI),今天仍有不少人觉得很新潮、高端。其实,机器人就是装备了人工智能的机器。

AI这个词最早诞生于1950年代,指的是制造智能型机械的科技。近年来这方面发展迅猛,仿人形机器人被认为是人工智能的终极体现。

就像科幻电影里那样?

现在,酒店和工厂里已经有机器人和人一起上班,无人驾驶汽车也已经上路测试,无人机开始送货服务,股票交易所的”中枢神经“是AI引擎,购物网亚马逊和网络电视Netflix用AI分析用户消费心理和习惯,据此推荐相应商品、书籍、影视,或者向广告商提建议,还有智能手机和iPad里的“私人助理”。

经过60多年的磨砺,人类社会似乎真的要进入AI时代了。

在智能和人工智能并存变成每个人的日常之前,先来看看银幕上的虚构角色和现实版的AI。

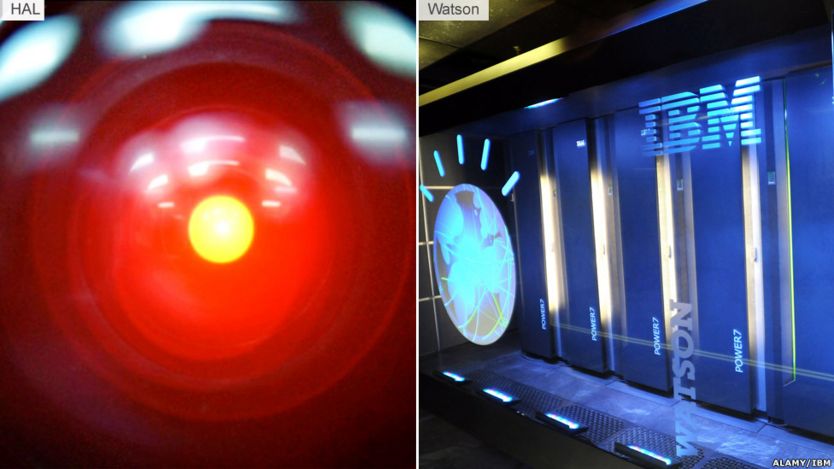

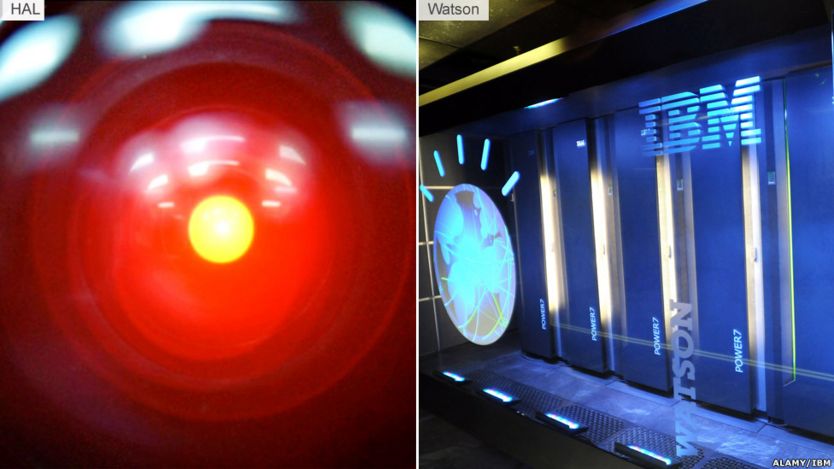

图片版权ALAMY/IBMImage caption[size=0.75]《2001漫游太空》里的反派角色哈尔(Hal)和当今世界智力超人的电脑沃森(Watson)。全知全能的机器人

图片版权ALAMY/IBMImage caption[size=0.75]《2001漫游太空》里的反派角色哈尔(Hal)和当今世界智力超人的电脑沃森(Watson)。全知全能的机器人《2001太空漫游》(2001: A Space Odyssey),斯坦利·库布里克执导的美国科幻片,1968年上映。

这部影片的主角,哈尔(Hal),或许是迄今为止最著名的AI反角。它的设计使命是掌控“探索一号”宇宙飞船的控制系统,还要跟飞船上的人员互动。但是,它很快就把人类撇在一边,开始了自己的使命。

Hal实际上是指启发式编程算法计算机(Heuristically Programmed Algorithmic Computer)。

银幕下的世界里,跟它最接近的要数IBM的沃森(Watson)。沃森是一台超级电脑,懂得自然语言,几秒钟就能阅读数百万份文件。

2011年,沃森参加美国电视智力竞赛节目《危险边缘》(Jeopardy!),击败了当时世界上最优秀的两名选手。

跟电影里的哈尔不一样,沃森与人类关系和谐,在很多领域携手共进:

- 在可口可乐、P&G之类跨国大公司的研发部门协助人类开发新产品;

- 为美国十几家医院提供服务,帮助病理学专家开发癌症新疗法;

- 融入一款恐龙玩具的电脑配置,让孩子们尝试体验跟AI交流沟通-孩子们可以问恐龙问题,沃森藏在恐龙体内帮助它回答这些问题;

图片版权ALAMY AND BOSTON DYNAMICSImage caption[size=0.75]电影里的“终结者”杀手机器人和波士顿动力(Boston Dynamics)公司开发的搜救机器人Atlas机器杀手

图片版权ALAMY AND BOSTON DYNAMICSImage caption[size=0.75]电影里的“终结者”杀手机器人和波士顿动力(Boston Dynamics)公司开发的搜救机器人Atlas机器杀手T-800是科幻片《终结者》(Terminator)里的杀手机器人,AI系统Skynet给它编的程序是去执行灭绝人类的杀手任务,这个AI控制了地球上的电脑中枢系统,它的目标是摧毁地球人类。

迄今为止,现实中还没有一款AI系统具有自我意识功能;现有AI的编程都是帮助人类实现某种任务的功能。一个例外是军用机器人。这种机器人要上战场,需要适应战场上的现实,辅助战士执行任务。

美国军方正在研发各种智能装备,比如让士兵具有超人般的力量,或者能眼观六路耳听八方,或者能帮助他们在战场做出更好的决策。

现在没有终结者那样的机器杀手。但是,美国波士顿Boston Dynamics公司开发的搜救机器人已经入使用。

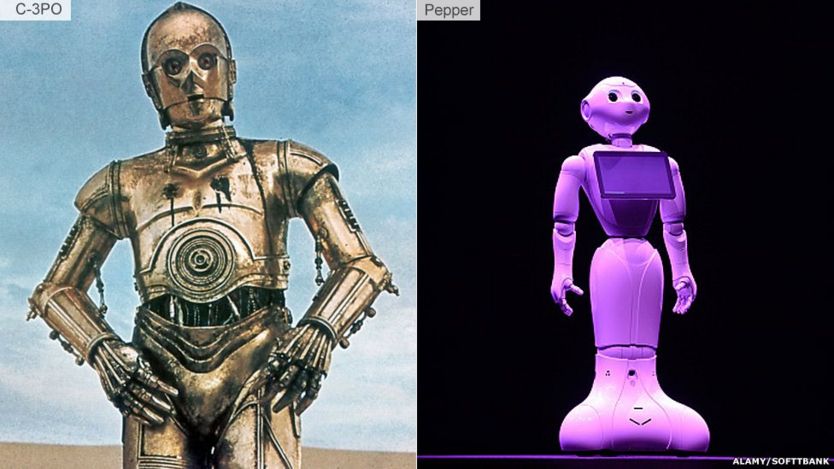

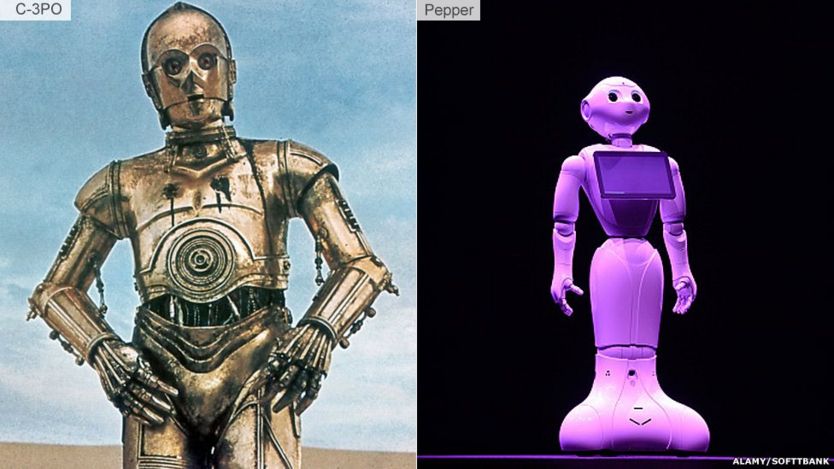

图片版权ALAMY AND SOFTTBANKImage caption[size=0.75]《星球大战》里的机器人C-3PO(左),日本软银公司研制的机器人“胡椒”2015年投放市场助手和伴侣

图片版权ALAMY AND SOFTTBANKImage caption[size=0.75]《星球大战》里的机器人C-3PO(左),日本软银公司研制的机器人“胡椒”2015年投放市场助手和伴侣C-3PO 是电影《星球大战》里的机器人,存在的目的是服伺、辅佐人类,据称擅长六百万种沟通交流方式。他的主要职责范围是礼仪、习俗和翻译,以便不同文化之间的交流能较顺畅地进行。

在现实世界里,这类助手伴侣式机器人已经开始蓄势待发。

日本软银公司开发的“胡椒”2015年夏季投放市场,几乎立刻售罄。

据称它能识辨人类的情绪和情感变化。如果主人回家时愁眉苦脸,不开心,它就会建议听听音乐。

这种“察言观色”的能力,它是通过看海量的人类面部表情视频学会的。

图片版权REX AND IROBOTImage caption[size=0.75]Wall_E 和 Roomba清洁工机器人

图片版权REX AND IROBOTImage caption[size=0.75]Wall_E 和 Roomba清洁工机器人Wall-E 是迪斯尼同名影片里的角色,它在电影里的任务是在人类离开地球后打扫清理这个星球。

现实版的清洁工机器人当然不需要承担那么宏大的任务,但同样能够替人类打扫卫生而显得可爱的机器已经诞生,就是智能吸尘器。

现在市面上最有名的牌子就是iRobot公司出品的Roomba;截至2014年2月,已经卖出1千万个。它自带感应装置,按编好的程序在屋里各处吸尘,完工后乖巧地回到大本营充电。

有传闻说一些用户对它产生了情感依恋,就像对宠物一样,带着它们一起去度假。

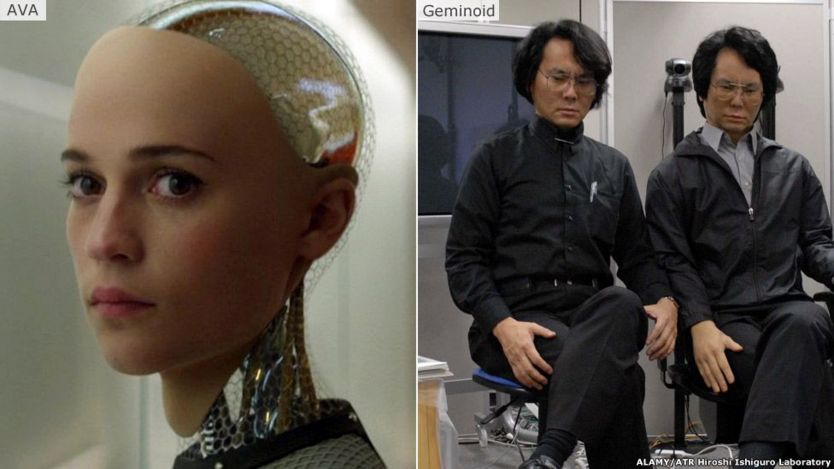

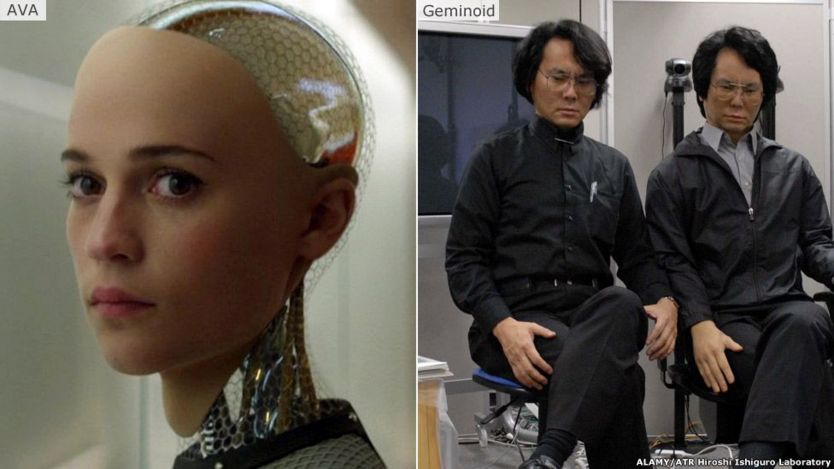

图片版权ALAMY AND ATR HIROSHI ISHIGURO LABImage caption[size=0.75]科幻片 Ex-Machina里的机器人女主角埃娃,现实世界里日本机器人专家石黑浩跟以自己为原型制作的仿真机器人仿真机器人

图片版权ALAMY AND ATR HIROSHI ISHIGURO LABImage caption[size=0.75]科幻片 Ex-Machina里的机器人女主角埃娃,现实世界里日本机器人专家石黑浩跟以自己为原型制作的仿真机器人仿真机器人埃娃(Ava)是2015年科幻片 Ex-Machina里的机器人,具有真人般的躯体。这个虚构的机器人堪称AI的终极版本。

她(它)看上去就是一个真人,能跟人谈论任何话题,能表达跟人类的共鸣、同感。然而,埃娃又确实是“人工智能机器”,有自己的只属于机器人族群的计划和谋略。

而这也正是最令人类害怕的AI。

现实中,埃娃那种真人外形、智能超人的机器人还没有出现,但确实有一些这方面的尝试。

日本机器人专家石黑浩按自己的外形容貌仿制了一款机器人,取名Geminoid,用来研究人-机互动。

他的仿真机器人用硅胶作皮肤,但更逼真的的版本或许指日可待:已经有生物工程技术公司和化妆品公司合作,用3D打印机“打印”出人类皮肤。

软件公司IPsoft开发了一款虚拟助手,取名阿米莉亚(Amelia),目前还在虚拟空间飘着,但公司首席执行官杜贝教授坚信,几年之内,AI就将与机器结合,生成仿真机器人;届时,阿米莉亚将走出虚拟时空,踏入现实人世,酷似真人。

像电影里的埃娃那样?

https://www.bbc.com/zhongwen/simp/science-39793434

作者: 刘海明 时间: 2018-12-17 23:21

【案例】

从BBC到路透社 人工智能怎么做新闻· 2018年9月 26日

file:///C:/Users/35242/AppData/Local/Temp/msohtmlclip1/01/clip_image002.jpg图片版权GETTY IMAGES

从人工智能进驻新闻机构,写稿机器人交出球赛、股市新闻稿,到机器人抢独家新闻,前后不过三、四年时间。

刚开始记者们半开玩笑地表示担心机器人会抢走自己的饭碗,后来大家热议机器人写的足球赛新闻比人写的差距多大,再后来,到了现在,关于AI的关注又变了。

人工智能将如何拓展、重塑新闻采编制作流程中的哪些环节?以前有哪些难以想象或不可能的设想借助AI的威力而成为可能?又有哪些环节确实可以而且正在取代人工?

AI在新闻编辑室可以发挥什么作用,这是个自由放飞想象力的话题。

抢独家人工智能跟人类争普利策奖?其实1988年就发生了。《大西洋月刊》记者比尔·戴德曼(Bill Dedman)在电脑帮助下检索梳理了海量的住房按揭数据,写出系列报道揭露这一行的隐形种族歧视,作品获当年普利策奖。当然,这可以算作机器夺奖。

机器跟人抢独家新闻?这事4年前有人预言过:会编程的记者将能抢先报出独家新闻,抢头条。

机器人工程师约翰·基弗(JohnKeefe)今年1月在哈佛大学尼曼新闻实验室(Nieman Lab)2018行业预测中断言,这件事今年就会发生。他说,记者将运用AI抢得独家新闻。

这跟机器人写足球、财经消息不同。那更多是数据分析整理,然后用自然语言程序组合成文。抢独家消息是通过机器学习技术识别、发掘出人类单凭自己的大脑难以捕捉到的重要事实和真相。

至于未来的媒体编辑室是否由AI主宰,或者人类和机器联合执掌,现在难有定论。

可以肯定的是,适用于工农业生产的逻辑在相当程度上同样适用于媒体内容生成:搜集资料、整理数据、核查事实、版面校对等,这些工序能够也肯定会大部分交给AI,编辑记者可以更集中心智用于创意、创新。

file:///C:/Users/35242/AppData/Local/Temp/msohtmlclip1/01/clip_image004.jpg图片版权TWITTERImage caption特朗普总统的推特帐号上不全是他亲自发的,人工智能可以识别。

人算不如机器算

人机合作已有先行者探路。美国《大西洋月刊》记者麦吉尔(AndrewMcGill)把一项枯燥而至关重要的任务交给了机器人助手,@TrumpOrNot,让它分辨美国总统特朗普的推特帐号下哪些是他本人发的,哪些是手下人代劳的。

这个助手利用机器学习和自然语言处理技术,把特朗普新发的推特文字跟数据库中的文档资料对比,然后做出比较肯定的判断。

麦吉尔在2017年3月发表了自己的实验结果时写道:

“机器算法找到的那些最有助于分辨一则推特讯息出自特朗普之手还是工作人员之手的线索,真的很有意思。大部分不是文字,而是特别的拼写和标点符号。”

比如,特朗普发的推特更频繁出现自己的推特名“@realDonaldTrump”,更喜欢用“媒体”这个词,但显然不爱用“#”,而手下代发的推特讯息里这个符号更多。

麦吉尔承认自己这个助手的知识库需要不断更新,尤其是作为识辨指标的关键词、习惯和特点。

file:///C:/Users/35242/AppData/Local/Temp/msohtmlclip1/01/clip_image006.jpg图片版权ANGELA WEISS/AFP/GETTYImage caption《纽约时报》大楼里确实正在发生机器抢人饭碗的事。

AI进驻媒体

专注于人工智能领域发展的科技网站TechEmergence对人工智能在几家主要西方媒体的应用做了梳理,勾画机器人进驻编辑室趋势的一个截面。

§ BBC新闻实验室:语义辨识

BBC的人工智能机器人叫Juicer ("榨汁机")。它的任务是把海量的数据,包括每天的新闻、专题报道、视频、其他媒体的消息、政府部门和互联网信息, 等等,用一种聪明智慧的方式联结起来,既方便调用,又有内在智慧逻辑。

"榨汁机"2012年上岗,每天吸进来自850个新闻机构的RSS信息推送,整合处理数据,把BBC和其他媒体的新闻报道分拣出来,然后贴上相应的语义标注,分成4类归档:组织机构、地点、人物、事物。

这样,记者要查找有关特朗普总统的最新消息,或者AI领域动态的信息,"榨汁机"就会迅速上网搜索,然后给出一个相关内容的清单。

这还比较枯燥。不久的将来,"榨汁机"的功能提高后,还会更贴心,读者鼠标在某个字词上停留兜圈片刻,它就能生成一个弹出窗口,提供相应的信息。作为电视广播媒体,BBC还在训练它在视频环境下弹出相关的信息。

§ 《纽约时报》:语义辨识和评论区管理

2015年,《纽约时报》大楼内来了个名叫“编辑”(Editor)的AI。它的任务是简化记者编辑的工作流程。记者写稿时可以用标签来标明关键词、标题或主题。随着时间推移,数据积累到一定程度后,机器编辑就能自动识别这些标签的语义,找到一段文字中最关键的部分。这样,记者查资料或核对事实就很便捷,人物、地点、事件、时间,分门别类,井然有序。

人工智能在那儿的另一项任务是管理读者评论区。它将来可能要承担的是目前共有14个人负责的工作,主要是每天分拣查阅11,000条读者评论。该报开设评论区功能的文章只占10%,如果用AI机器管理,则可以有更多文章开放评论区,强化互动,并节省开支。这个软件叫PerspectiveAPI,可以迅速分拣整理读者评论,使读者更容易检索到自己感兴趣的评论并展开讨论,或者避开无聊的撒泼耍浑式留言。

这是机器抢人饭碗的一个例子。

file:///C:/Users/35242/AppData/Local/Temp/msohtmlclip1/01/clip_image008.jpg图片版权DAVID DAVIES/PAImage caption2016年里约奥运,《华盛顿邮报》的机器人记者包揽了大量数据密集型报道。

§ 《华盛顿邮报》:自动化新闻写作

“自动化新闻”(AutomatedJournalism)也称“机器人新闻写作”,使用的写稿软件是Heliograf。2016年里约奥运会上初次上场。它对源源不断的数据分析整理后,把信息跟事先定制的新闻模板里的对应词句配对,然后组成新闻稿,发表在不同的平台。要是发现数据里有异常,它还会提醒记者注意。也就是说,整个里约奥运会期间,写稿机器人承担了大量有关比分和奖牌数的实时报道,记者则可以更多采写其他内容。

新闻自动化有两层含义,一是数量,二是目标定制。

比如关于英国脱欧,机器人写手可以生成面向英国读者、中国读者或其他国际读者群的不同版本;关于股市动态的报道,可能会有一段专门为你订制:大盘总体向上,但你上周要是没有卖那些IBM股票,那你的投资组合资产今天会有这么多。

换句话说,机器人可以在万里之外写出比本地记者更接地气的新闻报道,或者把一条枯燥乏味的消息变成热搜榜上人人关注的新闻。

file:///C:/Users/35242/AppData/Local/Temp/msohtmlclip1/01/clip_image010.jpg图片版权GETTY IMAGESImagecaption算法和机器学习在各行各业的应用进展迅猛,新闻媒体业也不例外。

§ 路透社:数据视觉化

路透社2016年跟语义辨识技术公司Graphiq合作,研发智能型的新闻发表软件,自带自由互动数据视觉化功能,涵盖范围宽泛多样,包括娱乐、体育和新闻等。这个发表软件可以在路透社开放媒体快捷平台调取数据。这些数据嵌入发表器网站后,数据世界化程序会实时更新。

§ 美联社:语义辨识、人工智能分析、自动化新闻

"自动化洞见"的另一个客户是美联社。早在2013年,美联社就开始运用人工智能来处理体育和财经数据,生成新闻稿。现在美联社的机器人叫NewsWhip,负责追踪、预测社交媒体平台上的趋势。除了跟踪新闻报道,它还可以向记者提供实时或历史时段的分析结果。有了这个助手,新闻稿的数据准确性提高,错误减少,记者编辑对新闻时事的把脉更精准。

美联社没有用人工智能来撰写长篇政治评论文章,但在用一款名叫Wordsmith的机器人来把盈利数据转换成财经新闻。

file:///C:/Users/35242/AppData/Local/Temp/msohtmlclip1/01/clip_image012.jpgImage caption机器人就隐身在电脑里。BBC的人工智能在数据库里纵横捭阖,整合海量的文字和音像资料。

§ Quartz数码新闻:聊天机器人媒体界面

关键词:聊天、自然语言处理、新闻、话题。Quartz2016年获得一笔资金设立机器人实验室,为记者们开发各种自动化工具。这是对新闻媒体行业大趋势的一种反应:新闻不但从纸面转到桌面电脑、手提电脑、手机,不久的将来还将通过物联网进入家庭和私人座驾。

简而言之,就是通过聊天、语音和其他新颖渠道来实现人机互动。这个尝试还在婴儿阶段,但已经可以看出端倪。用户输入问题和要求,比如新闻事件、人物或地点,聊天机器人根据自己的理解提供相关的内容。

Quartz的目标是开发出能够跟所有媒体平台流畅互动的机器人和人工智能。目前还没有最后确定下一步怎么走,但正在考虑的一些设想里包括一款编辑室机器人,帮助记者为新媒体空间编写新闻、生成数据。

英国《卫报》也引入聊天机器人,2016年在脸书帐户上亮相,主要工作是帮助读者选择阅读的版本、新闻推送时间,并负责推送;这职责明细看来跟客服比较相似。

file:///C:/Users/35242/AppData/Local/Temp/msohtmlclip1/01/clip_image014.jpg图片版权GETTY IMAGESImage caption机器有人力不及之处,也有不及人脑之处。

在中国写稿自2015年腾讯财经频道开中国机器人写稿先河以来,不少媒体人发现多了个机器人“同事”。

2015年 -

§ 腾讯财经:9月10日发表了Dreamwriter新闻写作机器人编写的经济消息(《8月CPI涨2%,创12个月新高》)。

§ 新华社:“快笔小新”11月开始为体育部、经济信息部和《中国证券报》写体育赛事及财经消息稿件。

2016年 -

§ 网媒今日头条:“小明”(xiaomingbot)在2016年里约奥运会期间每天写30多篇赛事简讯和赛场报道;

§ 《钱江晚报》:微软旗下人工智能机器人“微软小冰”上岗,在“浙江24小时”APP中开设“小冰机器人”专栏;

2017年 -

§ 《南方都市报》和凯迪网:与北京大学计算机科学技术研究所联合成立智媒体实验室,推出写稿机器人“小南”;

§ 《华西都市报》:机器人“小冰”开设专栏“小冰的诗”,独家发布新作《全世界就在那里》(外二首);

§ 《广州日报》:中国全国人大和政协两会期间,写稿机器人“阿同”、“阿乐”写出了政府工作报告热词分析、外交部部长记者会热点问题分析等多篇报道,还回复了公众关于两会知识的提问;

§ 《人民日报》:人工智能、语音机器人“小融”在春节期间上岗,在人民网和其他社交媒体平台与网友互动;

除了这些隐形的AI写稿程序之外,也有更全能、具备机器人形状的AI记者,如新华社的“i思”、《深圳特区报》的“读特”、浙江卫视的“小聪”和香港大公文汇传媒集团的“小宝”,可以出去采访和录制广播电视节目。

file:///C:/Users/35242/AppData/Local/Temp/msohtmlclip1/01/clip_image016.jpg图片版权GETTY IMAGES

取长补短也许,未来比较合乎逻辑的延伸方向是人和机器各自扬长避短。机器人不以优美的文笔跟人竞争,而是在人的脑力无法企及的地方取胜,比如把一条重大讯息写成几篇视角独到、见解深刻、分析精辟的报道,而且能够迅速把这几篇文稿个性化,生成数十万个针对不同受众的版本。

AI在各地的编辑室里的职务明细正在不断变化,从数据收集、整理和分析、交叉查证核实,到写稿、创作、编辑,再到重新定义新闻传媒专业和行业,速度令人目眩。

新事物难免冲击现状,带来新问题,试管婴儿、克隆、基因编辑,无不在某些方面挑战人类社会伦理。AI也不例外。这是另一篇文章的话题。

https://www.bbc.com/zhongwen/simp/science-45591003

作者: 刘海明 时间: 2018-12-17 23:22

【案例】

机器人都能写新闻 记者们真要失业了吗?· 2018年1月 30日

file:///C:/Users/35242/AppData/Local/Temp/msohtmlclip1/01/clip_image002.jpg图片版权GETTY IMAGESImage caption机器人新闻很快将成为新常态?

机器人跟记者并肩工作,写新闻,已经是一些媒体机构的现实。有些体育消息,如果不加作者名字,几乎可以"以假乱真"。

"机器人新闻"- 不是关于机器人的新闻,而是机器人做的新闻 - 在人类世界普及的速度超出了很多人的想象。

对于此刻正在电脑前写稿的记者们来说,似乎饭碗受到威胁,形势不太妙。

编辑室同事美联社的一套电脑系统已经能够从大量数据中筛选出新闻线索,编成新闻文稿;其中一部分混在记者写的稿件里一同电邮给报刊客户,而且不少还不加润色就被报纸采用了。

中国的新华社正在重组,以便让人工智能更深更广地融入编辑室工作。

《洛杉矶时报》自2014年就开始发布根据官方数据生成的地震预警消息。《华盛顿邮报》去年宣布将派机器人报道美国高中生足球赛。

机器人进入新闻编辑室,正值全球纸媒面临发行量下降和广告向线上转移的双重冲击。

file:///C:/Users/35242/AppData/Local/Temp/msohtmlclip1/01/clip_image004.jpg图片版权SHUTTERSTOCKImagecaptionAutomatedstories are becoming more prevalent, but at what cost?

在越来越多的行业,机器人都被视为人工劳动力的潜在替代,而且成本更低。一种预测说,到2030年,机器人将从人类手里夺走8亿个工作。但在新闻领域,它们能夺走的百分比有多少?

根据美联社的试验,目前阶段机器基本上只负责在海量数据中搜索有用信息,但美国的线上线下媒体提供的内容,越来越多出自机器。

2017年,设在牛津大学的路透社新闻研究院做的一项研究发现,欧洲各地的媒体每月发表成千上万篇机器自动生成的新闻,主要是迅速发布公众感兴趣的数据,比如选举结果和经济数据。

file:///C:/Users/35242/AppData/Local/Temp/msohtmlclip1/01/clip_image006.jpg图片版权GETTY IMAGES

荷兰一家通讯社在用机器更新写给未成年人看的新闻稿,使用的语言较简单。

迄今为止,已经上岗的机器人"头脑"比较简单。当然,在机器人世界,这种状况不会持续很久。

中国的腾讯最近亮相的一套系统可以自动写作一篇完整的演讲稿。

新闻网站Quartz的执行总编扎克·塞沃德(Zach Seward)曾用类似的系统写了一篇在大会发言稿,据说他对文稿很满意。

file:///C:/Users/35242/AppData/Local/Temp/msohtmlclip1/01/clip_image008.jpg图片版权GETTY IMAGESImage caption机器人,或新闻软件,将加入这些传统的记者工具?

但核心本领夺不走

然而,写稿只是记者工作的一部分。机器能就特定话题做电话采访吗?能写出有文采、直抵人心的报道吗?

技术上这是可能的,可以事先把问题拟好,让机器打电话采访。但编辑是否愿意这么安排则是另一个问题。

不过,更靠谱的判断是,机器人或软件将很快成为记者们手里的一个工具,用来搜寻新闻线索或生成内容。

这枚硬币的另一面,是工具被滥用。

在新闻和社交媒体行业,机器被用来生成和传播假新闻,也已经跟"机器手点赞"、“僵尸粉丝团”之类传统利用一样,成为一个现实而紧迫的问题。

社交媒体上已经出现这种迹象。

file:///C:/Users/35242/AppData/Local/Temp/msohtmlclip1/01/clip_image010.jpg图片版权GETTY IMAGES

不过,机器有机器的特长

需要声明,BBC目前还没有采用机器生成的故事,但BBC的新闻实验室正在研究让机器承担部分新闻采编和制作,包括听写采访文稿、检索公共数据找线索。

不过,记者的核心职责是从采集到的数据和信息中筛选、掂量、分析、权衡、组织,写出有理有据、有血有肉、全面平衡的报道。

这是一门活技术,代代相传到今天,经过百余年的演化。如果说机器人最终也能掌握这门人性比重极大的技术,那也不大可能是现在。

https://www.bbc.com/zhongwen/simp/science-42877951

作者: 刘海明 时间: 2018-12-17 23:22

提示: 该帖被管理员或版主屏蔽

作者: admin 时间: 2018-12-18 09:37

【案例】

编辑:付莎莎

作者: admin 时间: 2018-12-27 00:04

【案例】

机器算法与股市暴跌

编辑:臧博

作者: admin 时间: 2018-12-27 22:01

【案例】

场景、关系与算法:媒体融合创新的三重维度

移动化、社交化、智能化扑面而来,要在新的生态条件下进行媒体融合的科学创新和实践探索,需清晰把握场景、关系、算法的内在生成逻辑和路径。连接的变革、情感与信息的互动、人机的结合都是对其规律的深刻洞察与思考。

1

场景:连接的变革

根据CNNIC2018年6月的统计,中国网民8.02亿,手机网民7.88亿,中国已经成为手机使用的全球第一大国,这意味着我们已从去中心化的网络世界进入到移动网络传播时代,而基于场景的移动传播“不仅是一种媒介形态,更是一种信息场域和媒介生态,共同构成了网络传播的新语境”。在新的场景和生态中,信息的分发时间从定点转向随时,信息的分发空间从固定区域转向任何地方,单一的新闻信息、专业资讯已经转向多元的情感社交和日常生活。因此,移动传播时代的媒介融合本质是基于场景的信息服务。以往主流媒体是以专业的内容取胜,如今专业化的内容必须通过场景的争夺才能得以传播和反馈,否则将被信息洪流所吞没。

Robert等人在《Age of Context》中提出,移动设备、社交媒体、大数据、传感器和定位系统作为场景时代的五种主要技术力量推动社会变革。技术驱动的变革为商业互联网公司的探索提供了基础,因此,他们通过上述五种技术力量在市场中争夺的是不同的场景,求得生存并发展壮大,如微信和支付宝的竞争是支付场景的较量,OFO和Mobike争夺的是单车出行场景的体验。随着单一场景的争夺,逐步升级到平台阶段,即希望通过平台满足移动网民对多元场景的需求。微信从日常聊天、消费支付拓展到理财、生活缴费、城市出行、美团外卖、酒店住宿、京东优选等情感社交、生活娱乐、工作出行的主要场景,平台的发展包含现实的物理空间,也有心理和行为的期待、依赖。

媒体融合在发展升级的过程中需要充分认知媒介生态的场景化变革,将优质的信息内容在新的时间与空间、社交情感、日常生活的场景中进行科学有效的传播。人民日报主管主办的全国性财经证券类日报证券时报从1993年创刊至今的25年发展中,也在从传统媒体向媒体融合创新的路径进行转变。2008年《证券时报》创立网站并开始探索全媒体战略,完成从报纸为重心转向以数字媒体为重心。同时,证券时报形成了拥有7个网站、11个微博、29个微信公众号、7个新闻客户端,共54个数字平台的新媒体矩阵,覆盖用户数超过1300万。其中,“券商中国”通过独家行业报道、及时金融政策解读、热点事件跟进、专业行业数据分析等优势“吸粉”240万,“10万+”报道超过270篇。尽管融合创新的发展中取得不错的成绩,但是若能更多关注移动化场景网民的需求,其优质、专业、准确的财经内容将会获得更高效的传播,从而从金融的独特视角进一步提升我国金融舆论传播力、引导力、影响力、公信力。

2

关系:情感与信息的互动

互联网时代,我们面对的不仅是场景转换的变革,信息的流动方式与传播模式也发生了颠覆性的变化,从基于权威媒介中心向外扩散的“喷泉型”走向基于全社会个体关系的“网状型”。前互联网时代,大众媒体通过大规模的信息生产与强大的信息分发能力成为社会信息的权威集散地,通过中心向外延展来完成信息流动和对社会的信息管理,这是强化媒体中心而弱化人际连接的模式,但是网络时代截然相反,它的信息流动方式是依靠全社会的人际关系网络完成信息分发、反馈与互动。这在一定程度上弱化了原有媒体中心的权威,强化了人与人连接的关系网络,即从“点到面”转换为“点到点”的传播,因此“关系”成为网络传播的重要要素,媒体融合创新需要通过“关系”传播的有效连接来提升信息传播的“四力”。

网络传播时代的关系不同于此前的陌生人之间的信息传递,而是熟人之间,陌生人与熟人之间的连接,基于用户为中心的网络主要分为强连接和弱连接。在这个新型的连接渠道网络中,“强连接”主要是基于亲情等紧密关系形成的传播渠道,在社会的互动过程中,主要通过“情感”支持完成关系的建构;“弱连接”主要是基于熟人与陌生人、陌生人与陌生人之间形成的传播渠道,主要通过“信息”支持(如信息的分享等),完成关系的维系。这两种链接在移动网络传播生态中都发挥着重要作用,因为每一个个体都是信息的重要节点,尤其是其中的关键意见领袖(KOL),其情感动员和社会信息分享的聚能、扩散速度能力极强。在这个共同的社会网络中,一个点与更多的节点相连,形成了传播的脉络,可以说,连接即是传播。同时,网民连接起来的网络也形成公共空间,在这个空间中因连接起来(networked)个体网民的参与而变得有社会意义,因参与其信息网络,网民之间形成互动过程,因而出现传播的效果(如信息分享、情感支持、共同行动等)。学理研究的终结分析、点到面的线性传播都是大众传播的模式。然而,在新的网络模式里,探究线上线下的社会网络、传播渠道、互动过程是研究的重要内容,例如,公众用微信建立互相连接的社区、群组、圈子,进行日常信息分享、沟通感情,都是在一个特定的现实社会网络中(只有小区的居民可以加入微信圈子,非居民就不得而入)。因此,媒体融合创新的信息流动方式需要改变以往的路径依赖,转换到基于关系网络的传播路径中,唯此优质的信息内容才能在互联网的生态中快速传播、互动,达到预期的效果。证券时报在媒体融合创新中,从媒体自身的顶层设计思考,建立金融信息传播体系的媒体矩阵,在关系互动和接力式信息分发中产生了合力。

3

算法:人机的结合

媒体融合创新还面对大数据和人工智能算法的挑战与机遇。随着今日头条等聚合类平台的快速发展,基于算法生产内容(AGC,Algorithm-Generated Content)的方式已经成为网络生态下重要的信息生产和用户使用的方式。在大数据、云计算、智能化的发展趋势中,以用户为中心的算法时代已经到来。因此,传统的发行量、收视率、抽样统计在面对全媒体新的生态条件下已经难以适应,而是需要围绕用户建立数据库,并且根据用户行为进行数据分析,根据用户需求进行信息产品的生产和推送。在信息推送中,信息生产、传播、营销已经一体化、流程化和自动化,在矩阵的多平台终端上互联互通,在理念、内容、形式等多方面进行协同创新(精品内容+多微多端+线上线下+位置服务……),因此媒介融合创新的核心是以业态为重点的不断创新。

证券时报也在积极探索大数据和人工智能算法在金融信息领域的应用:2016年6月推出股市数据机器人,成为国内第一家把机器人写作植入到移动端的新媒体,每月人工智能生产深度数据信息超过3000条;2017年,上线国内第一款股市数据类工具型小程序——“数据宝工具箱”。“数据宝工具箱”自上线以来,月均访问次数为22万次,独立用户总数超过13万;新推出的雪球最近一年的阅读量破亿,在企鹅号和一点号财经影响力榜单上排在前列。目前数据宝机器人研发达150余类,涉及市场交易、上市公司财务体系、筹码变动、机构动向、融资融券、股东动向等类别。在媒体融合创新方面,不单单是信息内容生产后借助AGC完成接力式的传播,而是具有顶层设计的一体化解决方案,这样就很好地保留了用户数据,积累了重要的用户消费习惯,从而增强黏性与持续创新的资源。

然而,AGC在带来巨大生产力释放的过程中,也存在诸多隐忧。此类平台信息的生产与传播不再以传统的新闻价值作为重要的把关标准,而是以用户需求(偏好、兴趣、情感等)作为重要标尺进行信息推荐,通过用户在互联网的行为对其进行计算、画像,但这种计算存在用户偶然性使用与真正需求之间的矛盾。美国学者Sunstein针对此类信息生产提出“Information Cocoons”(信息茧室)的概念:以“Daily Me(我的日报)”的形式进行信息选择、推荐和传播,人们倾向于接受相似的意见而排除相反的信息,长期处于虚拟的共同体将容易导致群体极化的行为。机器算法的方式会进一步强化此类信息的茧室效应,即只接受自己选择和与自己观点相似的信息。因此,技术驱动的内在逻辑,需要与人本主义有机结合起来,才能更好地服务信息化时代人们对信息的需求,才是科学、有效、持续创新力的体现。

(作者:刘新传 系北京大学新闻与传播学院研究员、博士生导师,国家战略传播研究院学术部主任)

来源:新闻战线

编辑:马晓晴

作者: admin 时间: 2018-12-28 15:55

【案例】

制作短视频仅6秒!新华社发布首个MAGIC短视频智能生产平台

导读

12月27日新华社在成都发布中国第一个短视频智能生产平台“媒体大脑·MAGIC短视频智能生产平台”。这标志着短视频生产进入自动化时代!

“媒体大脑·MAGIC短视频智能生产平台”都能做些啥?给媒体带来了哪些福音?

新华社副社长刘思扬,新华智云联席CEO徐常亮在会上发表了讲话。

昨日,《传媒茶话会》对话新华智云科技有限公司新媒体VP商艳青。

生产一条短视频最短仅需6秒!

在第六届中国新兴媒体产业融合发展大会上,MAGIC短视频智能生产平台现场演示了大会短视频智能生产过程。仅27日上午,MAGIC短视频智能生产平台共生产186条短视频,其中97条机器生产,89条为人机协作生产。

新华社副社长刘思扬说,“媒体大脑·MAGIC短视频智能生产平台”的发布,对媒体变革和媒体智能化具有标志性意义。他认为,“MAGIC”让我们看到“媒体+人工智能”的广阔前景,它对未来媒体的生产、传播必然会产生重大影响。

新华社副社长刘思扬讲话

MAGIC短视频智能生产平台生产一条短视频最短需要多少时间?

“生产一条视频平均仅需50秒左右,最快的只要6秒。”新华智云联席CEO徐常亮表示,世界杯期间,MAGIC短视频智能生产平台通过算法进行进球视频的识别和切片,节省了大量时间。同时,这些片段都被进行了结构化、标签化的处理,未来如果生产一条类似“1-23号球员均有进球”这样的稿件,可以直接进行素材调取,花费的时间可能只是传统流程的几十分之一。

”新华智云联席CEO徐常亮讲话

那么生产的内容是否会千篇一律毫无新意?

“我们希望打造一条内容生产的流水线 ,这和以往工业时代的流水线的本质区别在于内容流水线的原材料本身具有多样性。”徐常亮表示,比如一个进球智能模板,由于每一个进球本身都是不同的,这使得模板生成的视频,无论是梅西和C罗的进球组合,还是C罗自身进球的组合都具有独特性和可看性。这个也正是内容行业的神奇所在。

MAGIC短视频智能生产平台能为媒体做些啥?

新华智云科技有限公司新媒体VP商艳青告诉《传媒茶话会》,新华社本次发布的“媒体大脑·MAGIC短视频智能生产平台”集纳了自然语言处理、视觉语义理解、音频语义理解等人工智能技术。能够实现秒级生成、海量生产、受众喜欢。利用先进的大数据和人工智能技术,结合对媒体场景的深度理解,对数据和媒资进行整合,帮助媒体实现“媒资素材搜索管理”和“短视频生产”的过程一体化、智能化、工业化。

具体分为以下四大模块:

1. 智能数据工坊

智能数据工坊利用语音识别,OCR,人脸识别等技术,将媒资素材进行由非结构化的数据变为标签化、结构化的数据,好比对原油进行提纯。帮助拥有海量媒资的媒体机构提高其内容生产效率,发挥数据价值。

2. 智能媒资平台

通过算法高度智能化、标签化处理的素材是“零件”,储存在仓库中随时可以被调用。

包含两万余个娱乐名人实体,一万余个人脸 ,近2000个政治人物实体,覆盖大部分地市级以上官员,并且不断更新中。

商艳青谈到,“当然,对于生产来讲,最重要的是生产资料,对于生产视频来讲,最重要的是媒资和数据,我们也在筹划中,与更多的数据供应商来合作,为视频生产提供服务。”同时,该平台上的机构用户也可进行素材共享,从而创造收益和价值。

3.智能生产引擎

MAGIC有自动识别能力,一旦“新闻仓库”里出现了具有较高新闻价值的结构化数据,譬如火灾、地震等突发事件,MAGIC会立刻提示使用者,帮助记者/编辑在热点报道中争分夺秒。在体育直播、金融等特定领域,MAGIC从数据采集到视频发布,实现数据可视化,数据视频化,视频自动化。

4.智能主题集市

MAGIC设置了多个智能模板,覆盖时政新闻、突发事件、体育赛事、时尚娱乐,金融等多个领域。

《传媒茶话会》了解到,除了MAGIC短视频智能生产平台,媒体大脑家族还拥有多个媒体产品可为记者赋能,比如,数芯帮助编辑找到选题,媒体大脑版权区块链实现版权存证自动化,媒体在MAGIC短视频智能生产平台上发布的短视频可一键式在公证处等机构进行版权存证等。

“我们相信智能化的内容生产有其通用性,无论是拥有大量历史视频、音频的广电媒体,还是拥有大量图片素材的报业媒体,只要有内容生产需求,只要生产短视频,都可以用到MAGIC。”商艳青告诉《传媒茶话会》,各行各业的媒体一直拥有自己的专业度和垂直抵达能力。MAGIC平台如今已经在体育足球这个场景进行了应用,实现了全程的自动化,也正在把AI能力应用到金融领域,应用到会议直播,应用到突发事件(比如火灾、爆炸、碰撞、地震等),应用到娱乐时尚等领域,未来会应用到通用的新闻领域。

“作为国家通讯社,我们很愿意向媒体开放这个生产平台,为你们服务,做大做强主流舆论,是我们的职责使命。”新华社副社长刘思扬表示,媒体要实现个性化制作、可视化呈现、互动化传播,今天发布的“媒体大脑·MAGIC短视频智能生产平台”是非常好的途径。它将助力采编人员,生产更多用户喜欢的短视频产品。

“MAGIC短视频智能生产平台于12月27日正式对外发布,媒体机构可在官网注册后,开通账号使用。不同套餐根据功能和权限不同,会有不同的收费标准。”商艳青透露,MAGIC平台自带简单的交互教程,总体比较方便上手。此外,平台也会提供相关的用户手册,如果媒体机构需要更详细的操作指引,或者希望对编辑记者有具体场景的培训,可以联系新华智云的工作人员获取进一步的帮助,平台可以安排在线视频协助等多种形式的支持服务。

来源:微信公众号“传媒茶话会”

编辑:马晓晴

作者: admin 时间: 2018-12-28 20:56

【案例】

耗资10亿证明AI无用?干货分享:教育大咖激辩AI+教育

CNNIC数据显示,2020年中国人工智能核心产业规模将超过700亿元,带动相关产业规模超过1万亿元,其中,「AI+教育」的市场规模达到3000亿。

任何技术的出现,对于教育而言都存在着一次融合、创新的机会。AI+教育,果真这样神奇吗?实际上,AI之风从2014年开始吹到教育行业,在2017年达到顶点,随后2018年开始回落。

12月中旬,在多鲸资本年会上,学霸君创始人张凯磊的「AI无用论」即刻引爆教育圈,引发热烈的讨论:有人说,再强的技术也比不上人类的神经系统;有人说,大数据题库结合AI逻辑,适当运用没问题;当然,也有人all-in,希望借AI引领行业……

张凯磊的AI无用论要点有二:1、花了10亿之后,发现AI技术还处在很初级的阶段,对教学没有用;2、即使是好的AI教育,也只需要帮助老师保证教学标准化水平。

对此,松鼠AI合伙人梁静独家回应传习邦(ID:chuanxibang):张凯磊说对了一半,也说错了一半。

借此机会,传习邦结合各位教育行业大佬们对AI的不同理解,组织了一场「隔空辩论」。现在,辩论开始,有请双方辩友上场——

正方辩友:

松鼠AI合伙人梁静、多鲸资本合伙人葛文伟、基因资本合伙人温慧生、兴旺投资创始合伙人熊明旺

反方辩友:

精锐教育集团兼巨人教育董事长张熙、学霸君创始人张凯磊、秦汉胡同国学创始人王双强

中立辩友:

睿泰集团董事长、总裁艾顺刚

- 1 -

真有用,还是伪需求

学霸君创始人张凯磊:

我的结论是,眼前所谓的AI技术对于教学没什么用。作为一个已经在AI技术花了10个亿的人来说,这句话听起来挺悲哀的。教育AI投了这么多钱,水平仅仅相当于放大镜,远远没到显微镜、核磁共振的水平。现代医学花了三四百年时间,多少优秀的人前赴后继,多少万亿的资金投入,仍然治不了癌症,试想我们怎么可以对记忆、认知产生影响?

松鼠AI合伙人梁静:

AI based Adaptive Learning在美国已经不是有没有用的问题了,Knewton号称1000万用户,ALEKS号称500万用户,十几家公司总计两三千万用户了,有个报告说未来三年每年增长率48%。

基因资本合伙人温慧生:

AI在一些特定领域、特定功能上是可以代替教师的,比如答疑,因为它毕竟就是一些知识点,另外少儿英语和低年龄段的教育,因为语音识别已经比较成熟。但是引导和激励AI老师还是没办法代替。

精锐教育集团兼巨人教育董事长张熙:

几年前很多公司搞高考机器人,说这是人工智能的重要的应用,当时很多同事说要投资,我们想了想,也看了看,最后还是决定不投。现在也没有人提高考机器人了,所以不要唯技术论。

松鼠AI合伙人梁静:

拍照答题有用,学生需要。高考机器人,确实没有用,因为不是教学系统。AI教育在类别上可以分为策略类和工具类,其中识别类包括拍照搜题、智能评测、智能阅卷等,应用了图像识别、语音识别等,目前还有类似脑科学、表情识别,其实都应用得不是非常成熟,而且更多的是工具类;而策略类主要是自适应的教学方法,自适应包括的测、教、学、练几个环节,也都是教学中最核心的。

- 2 -

老师重要,还是AI 重要

秦汉胡同国学创始人王双强:

教育的核心还是教师,是人。教育本质上谁都替代不了人本身,因为人是有血有肉是人的世界,技术只是在这个过程中的一个工具,本质上要有好的内容、要有很多好的老师。

学霸君创始人张凯磊:

考试本身是一个排名游戏,当AI把老师的教学管好之后势必会规模扩张,越来越多的人能学得好,如果到时候还能保证孩子的成绩排名不掉下去,那这样的AI系统就非常好了。AI今天唯一能做的,基本就是赋能老师、提高老师的水平,甚至AI能把这个事做好已经非常阿弥陀佛了。

松鼠AI合伙人梁静:

AI让老师讲课标准化、保持课堂效果的一致性即可这个说法错得厉害。AI的目的是千人千面,一定是大量的非标准化内容通过算法匹配非标准化的用户画像,不同学生的起点不一样,知识分布不一样,每个知识点上的敏感度不一样,性格偏好不一样。

兴旺投资创始合伙人熊明旺:

目前一些AI产品,长远来看还是可以在消除教育资源不平衡方面做出贡献,比如我们可以想象,一个AI老师一小时只收5-6块钱,这是绝大多数中国家庭能够承担的费用,这对不公平不平衡的现象是一个巨大的进步。

- 3 -

技术难关,能不能克服

多鲸资本合伙人葛文伟:

AI会比移动互联网在教育上有更大应用的前提。我们说PC互联网和移动互联网是教育场景发生了迁移,学习效率有了很大的提升。本质上,并没有改变教与学的链条,也没有让教育企业整个运营收入成本比发生变化,但是AI能够解决这个问题。

精锐教育集团兼巨人教育董事长张熙:

在教育行业,应不应该唯技术论是值得探讨的。教育的核心还是体验,技术只是一个手段。一家做教育的公司说要改变教育,变成一家技术公司,凭什么?难道谷歌、BAT不比你擅长做技术吗?真正技术改变教育也轮不到我们做这个事情。

学霸君创始人张凯磊:

中国高考不是标准化的考试,浙江新高考改革说明:哪怕一整个省,都支撑不起每年持续稳定地输出一张难度系数一致、考察范围可靠、有效的考卷。一张有质量的考卷成本非常非常高,需要的样本量出不会少于一个亿。

多鲸资本合伙人葛文伟:

拜移动互联网所赐,今天的教育工作者已经形成很大量而广泛的数据库,使AI在这个行业爆发不再有缺失数据的拦路虎,使教育彻底改变因为人的结构而产生的模型。

睿泰集团董事长、总裁艾顺刚:

中国的企业普遍太盲目自信、太单打独斗了,觉得自己什么都能做。实际上分段协同很重要。教育这个行业太大,大到谷歌、甲骨文、Facebook这种量级的公司都认为,单凭科技公司是不可能整合教育的。同样,教育公司也不可能自己研发科技。所以他们通过信息管理系统(IMS)这个组织,找到一些比如统一的数据接口、协作的方案,去探讨法律法规的边界问题,比如将来的数据应该归属谁。在这样的生态环境下,他们才达到了强强联合。

- 4 -

大势所趋,还是无疾而终

多鲸资本合伙人葛文伟:

如果说上一个周期(2004-2014年)最重要的核心是互联网,那么下一个周期(2025-2035年),核心毫无疑问是人工智能。行业目前这个周期正处在下行阶段,教育跟移动互联网结合的红利的尾巴转向教育跟AI红利的结合,我们预测2022年左右我们经济周期是往上走的,使教育完美地跨越这十年周期。

基因资本合伙人温慧生:

我觉得下一个五年很重要的投资方向是AI+教育。传统教育服务企业成功的核心是提供优秀教师和好的内容,到了AI+教育,更多的是数据和算法。这样一来,对创始人的基因要求就变了,必须是技术导向,他要理解技术、理解AI对企业商业模式有多大影响、可以延伸出哪些商业可能性。

精锐教育集团兼巨人教育董事长张熙:

自从人类进入工业社会以后,出现了蒸汽机、电报、电视、广播等各种新技术,但现在的教育场景跟1000多年前还是很类似。过去几年讲AI/VR,火了五年以后无疾而终,连谷歌和Facebook都没有挣到什么钱,AI/VR与教育场景最契合的技术也没有大的突破。

秦汉胡同国学创始人王双强:

在这个时代,让技术为我所用是一个基本需求,让产品在线化、让组织和资源做数字化升级是任何商业机构必然的素质。把会用手机、会用微信、会坐飞机、会坐动车作为核心竞争力,是非常可笑的事情。随着时间的推移,技术会越来越边缘化,不管你是AI还是什么,适可而止,恰当好就够了。

兴旺投资创始合伙人熊明旺:

如果从市场上变与不变的因素来看,教育需求和教育公平没有变,行业需求提升没有变,变的部分是指移动互联网红利变成了AI红利,或是下一代VR交互体验的红利。我认为,教育行业整体行业集中度未来五年十年有一个持续提升的过程。

最后总结+感言,睿泰集团董事长、总裁艾瑞刚:回到商业的原点,我们谋求解决的,其实是一个投资回报率+用户服务效率的问题。科技+内容+服务,三个环节都很重要。现阶段,是不是一定要把AI加到产品上去?不见得。每个企业不一样,要自己衡量。

特别鸣谢:多鲸资本

本文由传习邦独家于2018年12月28日原创首发,未经许可不得转载。关注传习邦(微信公众号ID:chuanxibang),深刻洞察教育行业。传承学习,教育兴邦。

来源:传习邦

链接:https://mp.weixin.qq.com/s/snmu5QXdc5qR1u5erTWSVg

编辑:马晓晴

作者: admin 时间: 2018-12-28 21:23

【案例】

无所不能的AI能帮你写年终总结吗?

又双叒叕到了年终总结时,想必你正在苦思冥想如何写一份高质量且不落俗套的年终总结吧。上周我也收到了开年终总结会的通知,和你一样,我也为写总结挠头。当时我刚好编完一篇人工智能终将取代人类诸多工作的文章。文章中列举了365种工作的消亡概率(原文点这里),很多岗位看起来岌岌可危,我突发奇想,如果AI终将取代我的岗位,它是否也需要写年终总结?我刚为自己的脑洞感到兴奋,但一转念就发现这个脑洞一点也不清奇,因为AI的确不用。先不论AI并不是像机器人那样工作,即便真的在一些岗位上是那样,它还是不用,因为AI的职责相当明晰、绩效根本不用考核,关键是它不用管已经发生的事情,它只需要专注眼前和未来(比如深度学习)就好。

想到这里我突然发现,这其实是一种非常理想的员工绩效管理状态——不用写年终总结,员工不用总关注过去发生的事,而是专注于眼前的工作,以及如何在未来提高。而且,这不是我的脑洞,这已经是许多公司在绩效管理上践行了多年的最佳实践。

写不好年终总结也许不是你的错

年终写年终总结,这件看起来天经地义的事儿,其实已经在很多公司被取消了。沃顿商学院管理学教授彼得·卡佩利,和哥伦比亚大学人力资本管理教育项目教务主任安娜·塔维斯就在发表于2016年10月的《绩效管理新方向》一文中指出:许多公司都取消了年终总结,因为年度评估最大的缺陷是:由于过度强调财务奖惩,且必须在年终进行,它迫使员工为过去的表现负责,却因此难以提升当前表现,以及培养未来技能,而这两项才是企业长期生存的关键。

社会科学研究显示,员工痛恨数字评分:相比满分5分被评为3分,得到“中等”的评级更容易接受。员工还厌恶强制排名。沃顿商学院伊万·巴兰基(Iwan Barankay)的实地研究显示,当他们被评价的方式是与他人对比时,员工的表现反而比之前更差。而且评价也可能不客观,对评估结果的研究不断显示,评估者给和他们相似的人打分更高。因此,评估者对评估结果的影响,不亚于员工的实际表现。

对管理者的调查反复显示,他们同样不喜欢评估员工。韦莱韬悦的研究发现,45%的管理者不认为评估体系有价值。德勤报告称58%的HR高管认为,管理者用在绩效评估上的时间是低效的。

据CEB估计,2014年,12%美国企业完全取消了年度评估。韦莱韬悦得出的数字是8%,但同时指出29%的企业正考虑取消评估或有此计划。

德勤是取消年度评估的积极践行者,它们采用更标准、更透明、更频繁的评估体系,取代了一年一度的考核,提高管理效率的同时降低了管理成本。(详见《哈佛商业评论》2015年10月刊《重构绩效管理》)

你看,年终总结,作为绩效评估的重头戏,正在被越来越多的公司抛弃,取而代之以更符合当前人才发展需求、更加敏捷,以及更以团队而非个人为中心的绩效管理方式。因此当你感到年终总结不好写,年度评估不公平的时候,那也许不是你的错。

还是要写年终总结AI能不能帮你写?

不过读者也不要急于把写不好年终总结的帐算到企业头上,并非每家企业都出于同样的业务压力,需要改变绩效评估体系。在有些领域和行业,如销售和金融服务,仍有必要强调职责和针对个人的财务激励。对于公众负有重大责任的组织,传统绩效评估模式仍可能非常有效。

既然注定还是有很多人要写年终总结,聪明的读者一定会想到聪明的AI能不能帮我写年终总结呢?答案还是不能。

《哈佛商业评论》英文版高级编辑沃尔特·弗里克就深入研究过AI写文章的水平到底几何,结果发现,AI可能在撰写摘要、提炼核心观点、提升调研速度上尚可胜任,但目前它还写不出合乎逻辑的长文章。他指出,如今,AI的运作原理是将任务转化为预测问题,之后使用统计技术和海量数据完成预测。举例来说,短信类预测问题之一是自动完成(auto-complete)。如果你将“还算”作为一段话的开头,你的手机就会通过数据和统计模型预测接下来的文字,比如“顺利”“好”或“比较”。你想打的是“顺利”,而选择这个词之后,手机就会接着预测下一个词。这次它非常自信,只给你“吗”的选择(确实是正确的预测),然后直接跳到下一个词汇的选择,比如“和”或“今天”。

但我们不能把写一篇突出成就、展示成绩、描述职业愿景的年终总结变成预测问题。

关键是,AI没有叙事能力。2016年在机器学习的协助下,一个名为《阳春》的剧本诞生。研究人员将数十本科幻电影剧本逐字输入到神经网络(机器学习算法类型之一)中,神经网络学习剧本的特征,比如台词应分配给不同演员,而且剧本中要写清楚舞台指示。神经网络只读了几十部剧本,就学会以上所有技能,但它没有从这些剧本中学到叙事艺术。《阳春》没有故事情节,角色只是为了说出分配给他们的台词而存在。这部剧本说明,机器学习在成为叙事大师,或者说获得“智能”的路上,还有很长一段路要走。

你看,人类有很多能力是独特而难以复制的,至少迄今为止,AI再聪明甚至都不能帮你写好一份年终总结。

还是要自己写年终总结你可以这么写

那么,作为一个活生生的员工,我们该怎么写好一篇生动的年终总结呢?玛莎·萨缪尔森,作为一家咨询公司的CEO,就曾对如何写好年度总结给出了如下建议:

了解上司如何使用它。你的自我评估当真被用来评估你,还是只是HR的例行公事?你的上司是否会基于它来决定你的升职和奖金?一些比较懒的上司会将这些自我评估直接剪切并粘贴到公司综述里。如果这是你上司的所为,你可以用一种方便他这么做的方式来写。

突出你的成就。不要傲慢,但是也不要淡化你的成功;以谨慎的方式承认错误:不要让你的老板抓住“牵制你的把柄”,你应该顺便提到不足之处,但是要确定能用其“转为利好的一面”。

聚焦于你自己。批评别人很容易,尤其当他们干扰了你的工作,但是要记得,这份评估是关于你的,同事间的问题跟你的上司沟通,但是不要写在评估里。

提出你的要求。聪明的员工会运用个人评估来赢得更多发展机会。要具体详细说明工作中哪些让你兴奋,哪些你还可以更多地参与。但要确保你的要求合乎你所在部门的业务需求。

你看,写好一份年终总结并不难。其实,在任何时代,每个人都有不可被取代的一面,也许它并不直接表现在工作上,但你要相信,你是独特的,是人类多样性、多元化的一份子,是这个世界如此缤纷的原因,这既无法被其他人替代,更不会被AI替代。好了,写了这么多,我也该去写我自己的年终总结了。

最后,也祝你的2018值得记取,2019值得期待。

李源 | 文

李源是《哈佛商业评论》中文版编辑总监。

来源:微信公众号“哈佛商业评论”

编辑:马晓晴

作者: admin 时间: 2018-12-31 11:39

新闻传播经验应用在机器写作技术开发中的个案研究

韩晓乔张洪忠 新媒体观察 2018-12-28

摘选自《全球传媒学刊》(2018.4)刊发的《文科思维与技术思维的碰撞:新闻传播经验应用在机器写作技术开发中的个案研究》一文,仅为部分内容,有些段落只有主题句,或者整段删除,全文参见刊物内容。

作者:韩晓乔 张洪忠 何苑 石韦颖

问题

本文对北京师范大学新闻传播学院参与微软小冰项目组开发“小冰白盒写作辅助工具”的过程进行个案研究,从北师大团队角度探究以下问题:资讯聚合类新闻文本自动化生成原理及模板生产模式为何;新闻传播专业经验如何使得机器新闻写作文本更接近人类写作文本;文科思维与技术思维的差异体现在什么方面以及如何进行磨合。

本研究采用个案研究方法探讨问题,以北师大新闻传播学院团队参与微软小冰“小冰白盒写作辅助工具”开发过程的个人经验为研究对象,并结合前期的11次讨论会的会议记录文本及项目合作期间产生的其他书面资料辅助分析。此前几乎没有关于新闻传播专业人士参与到机器新闻写作工具设计开发层面的记录与研究,希望本研究对后续相关研究能有一些实践层面的参考价值。

参与开发过程

在2017年9月16日北京师范大学、微软和封面新闻联合成立了“人工智能与未来媒体实验室”,在2017年11月16日封面新闻举办的“智创未来2017C+移动媒体大会上,微软亚洲互联网工程院小冰团队的总经理曹文韬和北师大新闻传播学院张洪忠教授商定,张洪忠教授团队参与到微软小冰机器写作的开发工作之中,作为“人工智能与未来媒体实验室”的一项实际工作。

2017年12月初,微软小冰团队与北师大新闻传播学院张洪忠教授团队(后面简称“北师大团队”)正式展开合作,在微软小冰团队前期工作基础之上共同合作探索出一套可行的资讯聚合类新闻机器写作模板生产模式。张洪忠教授团队人员有:张洪忠教授,讲师刘茜博士,博士生何苑,硕士生韩晓乔、刘力铭、石韦颖、丁磊、王小月。项目合作分为两个阶段。前期双方团队每周开展1-2次讨论会,交流工作进度、探讨修正方案和布置工作,先从聚合类娱乐新闻的机器写作开始。后期北师大团队的博士生、硕士生以实习生身份进入微软公司,与微软开发团队一起将验证可行的聚合类娱乐新闻模板生产模式推广到科技、体育等更广泛的写作领域。

整个项目的工作可以分为六个部分,由北师大团队和微软小冰团队分工合作完成:(1)行业内容结构梳理:以娱乐新闻为例,建立文章类目表,设计机器写作逻辑框架。这一部分主要由北师大团队完成。(2)对应行业结构,将不同观点态度的文章写作手法归纳总结,并形成相应的机器可以理解的模板进行学习训练(3)数据补充与模型训练:工程师给予对应模板模型收集人类写作文本作为机器学习对象,并进行算法模型训练。由微软技术人员负责。(4)效果评估:在讨论会上共同阅读分析测试文本,检验模板和算法的可行性,以改进方法。由北师大方面在微信群、微信公众号、今日头条发布机器生成完整新闻文本,观察受众反应。(5)向科技、体育等领域扩展:在项目后期,北师大团队部分成员进入微软公司与小冰团队一起将验证可行的模板生产模式推广到科技、体育等更广泛的写作领域。(6)模板编辑工具开发:模板编辑工具的开发与模板架设同时进行。微软团队负责产品设计与开发,北师大团队从用户角度提供需求。

之前的机器写作工具主要生成财经、体育类别下的快讯类新闻,以填充描述性数据为主。就是“人”先设计好写作内容的格式,机器只需要搜索并匹配相关内容到格式中,就可以像做“填空题”一样完成报道的简单写作。[虽然在大数据和算法技术支持下,机器写作已经可以实现同一主题下多事实信息的聚合,但也只是对信息的简单聚合,无法在将碎片式信息串为整体的同时兼顾文章中心思想的呈现,因此生成的文章不符合人类阅读习惯。

微软小冰团队和北师大团队为了使“机器写作”向“人类写作”更靠近,需要将不同观点写作手法的规律总结为机器可以理解的形式,然后指导机器去寻找对应观点态度的数据来成文。同时,机器生成文本需要使用人工编写的语句衔接,并采用更符合人类写作逻辑的结构组合。因此,要开发出一套更接近人类写作的文本生成工具,除了技术开发外,还需要了解传播规律和新闻写作技巧的专业人士参与写作模板的设计。

2018年7月26日,微软召开第六代微软小冰发布会 ,发布会上推出“小冰白盒写作辅助工具”,该工具由微软小冰团队与北师大团队合作开发,旨在帮助媒体从业人员快速搜集、聚合报道所需要的事实信息并形成新闻初稿。根据用户的需求,该工具可以实现对同一事件选取不同观点态度进行报道的功能。

机器新闻写作模板的生产模式

机器写作的模板由报道主体、人工衔接语、标签、段落选取规则组成。模板限定了文章的写作框架、事实信息的排列顺序以及情感倾向。模板的设计和衔接语的编写都会影响机器生成文章的逻辑和流畅性。

要想实现批量、自动化生成更接近人类写作风格的文本,就需要找到人类写作逻辑与机器写作逻辑的契合点,开发出一套通用的模板生产方法论。北师大团队和微软小冰团队以娱乐新闻为切入点,探索出了一套以情感态度为关键的资讯聚合类新闻机器写作模板生产模式。

模板主题选择:记者思维

从简单的罗列事实到形成完整的文章,需要有一个主题支撑。主题不同、模板的设计也会有所不同,模板的主题就是文章的主题,在这里也就是自动生成文本的类型。

在进行具体模板框架设计之前,首先要确定模板主题的分类方式。建立新闻的三级类目,例如将“娱乐”作为一级类目,对娱乐新闻的主题进一步细分作为二、三级类目。分类既是每个模板生成文章的主题,也是记者使用机器写作工具时选择的生成文本类型,设计的好坏将决定媒体工作者能否迅速找到自己想要生成的报道。

北师大团队在收集并阅读了近五年娱乐大事件的相关报道后,发现娱乐新闻和娱乐相关的微信公众号文章往往以最新发生的事件为引,再追溯事件涉及人物的相关历史新闻,最终形成一篇内容丰富的聚合类娱乐资讯。结合新闻写作的专业知识,团队经讨论决定从新闻报道事件类型的角度对模板进行分类,也就是在娱乐下首先建立包括绯闻、违法、综艺、奖项、时尚活动等在内多个二级类目,再在每个二级类目下建立三级类目。比如“绯闻”下的三级类目是“未婚绯闻情侣”、“出轨”等。每个三级类目既代表一个文章主题,同时也是新闻模板引语部分陈述的事实信息。这样设计文章分类,为的是令记者在遇到突发新闻使用工具生成文章时能迅速根据事件类型找到所需模板生成文章。

记者思维强调以事实的时间性和重要性排列事实信息,改变时间线的叙事结构,这一点也被应用到后面的模板框架设计当中——先报道新近事实,再根据重要性盘点相关历史事实信息。

人格化关键:情感态度

“机器没有情感态度,人类才有,可以通过不同事实组合呈现出差异化的态度。”在第四次的讨论会上,为了使机器生成文本从罗列事实到呈现观点态度,北师大团队提出在三级类目的基础上将同一主题的模板根据情感态度再次进行分类。在定下模板主题分类方式后,选取二级类目“绯闻”来设计模板。经过讨论,决定以“未婚绯闻情侣”为例,分“批判/祝福”两种态度来进行模板写作。由新闻传播学院的学生编写衔接语、制定段落标签(段落主要内容)并设计文章结构。此次写作的两个模板主要区别体现在衔接语的表达上,段落标签选择和顺序上几乎没有差别。

模板写作测试:调整技术与模板

微软团队工具的开发伴随着不断的测试和结果评估,以改进算法和模板设计,直到达到最佳效果。

在第一次情感态度驱动的写作模板完成后,微软团队将“刘雯/崔始源”、“吴昕/潘玮柏”这两对绯闻情侣的名字输入到模板中进行测试,生成了四篇机器写作文本。第五次讨论会上,北师大团队和微软团队对结果共同进行了评估。

讨论会上决定将同一个三级类目下不同态度的模板架构加以区别,以突出表达情感态度。

特别有进展的一点是,加入了观点和态度这两个全新的标签,进行数据模型的深度学习。

对于数据的聚类成文后,还要进行对应内容的二次改写。

“树”的搭建:写作的模式化量产

在确定了模板设计的基本思路后,需要考虑同一主题模板的量产问题,即如何在报道同一主题事件时自动化生成大量不重复的文本。

方法论推广

在“综艺”和“出轨”主题模板验证了流程的可行性之后,北师大团队里的学生成员进入到微软公司,将方法论推广到科技和体育领域。具体模板生产流程有五步。

文科思维与技术思维的碰撞

写作是偏文科思维的任务,而机器写作的工作原理是理科逻辑,这就要求学科交叉共同合作,来达成目的。北师大团队均为人文社会科学学科背景的师生,而微软团队则多为理科背景的技术开发人员,两种不同学科背景和思维模式的团队在合作中逐渐显现出明显的学科差异。但双方通过深入沟通促进相互理解,擦出了新的火花。

时间线与新闻价值

微软小冰最初生成的文本基于时间线叙事,预设模板是将事件按照发生顺序罗列,在北师大团队看来,这样的文本固然叙事清晰,但机器组合的痕迹依然明显。通常,新闻写作常用的“倒金字塔结构”会将更重要的内容放在前面,这样才能吸引读者继续读下去。要完成一篇合格的公众号文章也需要有故事的起承转合,有戏剧性的文章有起伏才有人看。模板的事件分类和情感态度主导也是基于这种文科思维来设计的。

对技术部门来说,无论是时间线,还是反转式的故事,只要有清晰的规则就能实现,重要的是规则。

规则化与概念先行

人类写作的思维是将若干个概念串联在一起,有了一个概念,概念的涵义自然就在脑海中被解读并检索出对应的具体信息,实现概念的具象化。但是如果仅仅给出一个概念,对机器来说是无法理解的。在会议上北师大团队的成员经常被技术人员追问某个标签的具体含义,因为只有技术人员将明确的外延和内涵写成规则,机器才能理解。最初北师大团队给出的模板中有“互动”、“产生社会不良效应”等含义广泛的概念作为标签。人与人尚难以给出同一概念界定,机器更难理解。为了解决概念模糊机器无法理解的问题,团队采取了多种优化措施。比如“互动”这个词,作为标签,边界宽泛,需要更具体的解释。机器不能理解抽象定义,所以要对标签进行意义拆分,拆成更具体的子标签。北师大团队首先将“互动”拆成了“节目互动”、“剧组互动”等子标签,并且通过举例让技术人员知道每个子标签代表的具体内容,再根据例子写成规则训练机器。

技术逻辑是一种规则嵌套,机器无法独立完成概念的具象化理解,文科思维需要再向前走一步,帮助机器完成概念的具体化,技术思维则将明确的文字规则编成程序,二者共同构成人类思维与算法之间的桥梁。

自动化生产与个性化创作

技术思维讲求一个算法解决一类问题,一个模具批量生产大量产品。人类写作与机器生产不同,常常被认为是个性化的。模板衔接语是机器生成文章当中人工写作的部分,一套模板衔接语理论上要能够被用于同一主题(比如“单身绯闻情侣”)下同一态度的所有情境,不论“小鲜肉”还是“大叔”作为绯闻对象要都能够带入同一模板。在北师大团队和微软小冰团队的讨论会上,争议最多的要数衔接语的通用性问题。微软方面提出一些词语无法套用所有艺人身上,造成文章逻辑混乱;北师大团队中负责写衔接语的成员则认为完全删掉有指代性的词会削弱文章的生动性,文章语言会显得生硬。

自动化生产必然会牺牲个性化,但个性化正是人类写作的精髓。在这一问题上,最终双方也没有找到完美的解决方法。写衔接语的成员在用词上更加小心以避免使用指代对象有限的词语,但一些模棱两可的词语也被允许写入模板中。由此可见,通用性和个性化之间的权衡仍是需要人类完成而机器替代不了的。

结论与思考

一是要正确理解机器写作。那些认为机器写作可以完全替代人、或者认为机器写作有价值观的说法其实都是不准确的。现阶段机器新闻写作的原理是基于大数据驱动,通过数据检索、数据分析、自然语言处理等算法将所需信息填入人工设计的模板中,不能从真正意义上完成有逻辑、有态度观点的自动化文本生成。机器擅长处理海量数据,能够弥补人的大脑在信息储备、数据处理上的弱势,更快速、精准地找到完成新闻文本需要的信息,从而减轻人类的工作量。但由于技术的局限,机器不能理解复杂的逻辑关系,甚至无法区别主被动关系,因此仅依靠机器生成文本无法构成一篇逻辑严密的新闻报道。此外,机器还不能进行采访,只能引用网络上已有的信息。也就是说,机器写作无法采集到线下事实,只能按照“人”设定的模块来写作,只是一个基于算法的依赖互联网大数据来源的写作工具。

二是机器写作会很快成为传媒业内容生产的一个高效的辅助写作工具。机器写作在新闻领域更适合被当作一款写作辅助工具,来帮助人类处理海量复杂的信息,将人从反复枯燥的劳动中解放出来,但人的工作仍然具有不可替代性。媒体从业者在自动化文本生成工具的开发中担任着设计师的角色。专业的新闻编辑可以为机器新闻写作工具制定写作框架,根据不同新闻资讯的题材设计出更符合人类阅读习惯和信息需求的写作规则。机器写作还不可避免地需要人工写作的内容来进行完善——所有的模板衔接语均由人类完成。

三是在当前人工智能技术被广泛应用于传媒业的背景下,文科思维与技术思维的碰撞与合作将成为常态。学科如何交叉合作成为日益凸显的问题。在“小冰白盒写作辅助工具”开发的案例中,北师大团队经历了从完全的文科思维到理解技术逻辑并可以灵活运用的转变。理解技术逻辑使文科从业者能够更好地运用它。在机器写作项目中,写作功能需要文科思维,但功能由技术实现,新闻传播学院的师生在开发过程中担当了技术与功能实现之间的桥梁。越接近需求,越要使用文科思维,越接近底层技术实现,越靠近技术思维。比如文科思维判断生成文本需要有情感态度,理解机器的技术逻辑是聚合包含事实信息的文本后,决定通过事实的选择和顺序来使文章具有价值判断,这就实现了文科思维和技术思维的转换。文科从业者没必要完全掌握代码编写,只需要掌握技术逻辑和原理,将纯文科思维用技术思维进行解构分析,就能促成两者的合作。

四是目前新闻传播学术界有一个流行观点,即夸大机器写作的功能,担心机器写作会取代的人的思想而变得不可掌控,甚至走偏。其实,了解机器写作的原理后,就知道机器写作只是一个写作的高效辅助工具而已,本身并不能形成观点,其生成的文章背后还需要体现的人的观点。

[1]感谢微软亚洲互联网工程院小冰团队总经理曹文韬先生对文章提出的修改意见,以及感谢小冰团队的各位工程师和参与人员的合作。

[2]韩晓乔,北京师范大学新闻传播学院硕士研究生;张洪忠,北京师范大学新闻传播学院教授;何苑,北京师范大学新闻传播学院博士研究生;石韦颖,北京师范大学新闻传播学院硕士研究生。

[3] Kim D, Kim S. Newspaper companies'determinants in adopting robotjournalism[J]. Technological Forecasting &Social Change, 2017, 117.

[4]Carlson,Matt. The Robotic Reporter:Automated Journalism and the Redefinition of Labor,Compositional Forms, andJournalistic Authority. [J]. Digital Journalism,2014,3(3): 416-431.

[5] Zheng Y, Zhong B, Yang F. When algorithmsmeet journalism: The userperception to automated news in a cross-culturalcontext[J]. Computers in HumanBehavior, 2018, 86:266-275.

[6]金兼斌.机器新闻写作:一场正在发生的革命[J].新闻与写作,2014(09):30-35.

[7]张洪忠,石韦颖,刘力铭.如何从技术逻辑认识人工智能对传媒业的影响[J].新闻界,2018(02):17-22.

[8]邓建国.机器人新闻:原理、风险和影响[J].新闻记者,2016(09):10-17.

[9]彭兰.移动化、智能化技术趋势下新闻生产的再定义[J].新闻记者,2016(01):26-33.

[10] Thurman N, Dörr K, Kunert J. WhenReporters Get Hands-On withRobo-Writing: Professionals Consider AutomatedJournalism's Capabilities andConsequences[J]. Social Science ElectronicPublishing, 2017.

[11]魏峰.从个案到社会:教育个案研究的内涵、层次与价值[J].教育研究与实验,2016(04):24-29.

[12]王富伟.个案研究的意义和限度——基于知识的增长[J].社会学研究,2012,27(05):161-183+244-245.

[13]何苑,张洪忠.原理、现状与局限:机器写作在传媒业中的应用[J].新闻界,2018(03):21-25.

[14]何苑,张洪忠.原理、现状与局限:机器写作在传媒业中的应用[J].新闻界,2018(03):21-25。

B

编辑:陈心茹

作者: admin 时间: 2019-1-8 20:01

【案例】人工智能及其社会化应用的现状和未来——《全球传媒学刊》就社会化智能信息服务专访孙茂松教授

[color=rgba(0, 0, 0, 0.298)]

作 者 孙茂松:清华大学计算机科学与技术系教授 金兼斌:清华大学新闻与传播学院教授

摘要 人工智能技术在快速向前推进的同时也给社会结构与日常生活带来巨大影响,激发起关乎人类生存、社会秩序、价值存续、科技伦理等议题的讨论。人工智能带来的深层次社会影响需要予以审慎思考。作为我国人工智能领域的专家,孙茂松教授如何看待跨学科领域合作对人工智能研究的价值?如何解读现阶段人工智能水准与适用边界条件?人工智能技术在内容生产、信息分配、系统建构等领域的应用是否会给社会结构形态、文化景观带来深层效应?兴趣驱动下的人工智能产品研发有何意义?本访谈通过与孙茂松教授的对话,对以上问题予以较为详细的阐释。 关键词 人工智能;中文自然语言处理;适用性质;内容产消;自动诗歌创作 近年来,随着智能算法推荐在购物、内容生产、消费、社交乃至自动驾驶、智能家居等领域应用的深入,人们已经切实感受到人工智能对我们日常生活所带来的巨大影响。现实生活已经高度数据化:一方面,日常生活本身日益依赖于信息传播系统作为中介来组织和展开;另一方面,我们的日常生活又在不知不觉中以数字印记的方式被社会的多层次立体化监测系统进行着准全息式的记录。近年来,大数据和计算能力成为人工智能快速发展的双重引擎,社会化智能信息服务水平的提升,正在给社会的整体形态、行业结构、组织管理方式、权力分配带来深远的影响。在某种意义上,人工智能正在深刻影响社会运作所依赖的基本要素之内涵及其相对重要性,行业、工种、职业以及包括工作和休闲之间的界限在内的各种边界,都面临重新划分或洗牌的可能。以信息内容生产和传播为安身立命之本的新闻传播业,从行业整体结构到依附于其中的个体的命运,近年来所经历的那种不以个人意志为转移的演变和变迁,充其量只是这波正在浩浩荡荡推进的技术与社会双向形塑过程中的一个折射而已。

果如是乎?

“不识庐山真面目,只缘身在此山中。”环顾现实,放眼未来,也许现在我们除了对“人工智终将给我们带来什么”进行展望外,也应该对我们当下所处的阶段有清醒的认知。

2018年最后一期《全球传媒学刊》正是在这样的背景下,选择“人工智能与社会”作为其专题。配合这期专题研究,《全球传媒学刊》执行主编金兼斌教授代表学刊,就社会化智能信息服务的现状和未来,书面访谈了我国人工智能领域的著名专家、清华大学计算机科学与技术系孙茂松教授。

孙茂松 清华大学计算机科学与技术系教授,清华大学人工智能研究院常务副院长,清华大学计算机科学与技术学位评定分委员会主席。2007—2018年任计算机科学与技术系系主任、党委书记。主要研究领域为自然语言处理、互联网智能、机器学习、社会计算和计算教育学。国家重点基础研究发展计划(973计划)项目首席科学家,国家社会科学基金重大项目首席专家。在国际刊物、国际会议、国内核心刊物上发表论文200余篇,Google Scholar论文引用数6800余次。 访谈嘉宾简介

问:金兼斌教授 答:孙茂松教授

问:您是计算机科学家、计算语言学博士,您所领导的实验室名为“自然语言处理与社会人文计算实验室”,您还成功申请到全国哲学社会科学基金重大项目“基于大规模社交媒体的汉语模因传播机理量化研究”。可以说,跨学科是您身上特别明显的气质和特色,您的学生、如今已然成长为国内自然语言处理领域引人注目的新秀的刘知远老师曾评价您是“计算机学者中少有的有着深厚文化底蕴的老师”。我在您的微信朋友圈中,也不时能看到您以古体诗的方式对学术人生进行抒怀和评论,文采斐然。您如何看待您作为计算机科学家身上的这种人文符号和气质?这种人文底蕴是如何影响您在专业领域的研究的?就人工智能研究下一阶段的突破而言,基于不同学科的科学家间的合作,以及兼具人文社科和信息科学乃至生命科学知识背景学者的跨界合作,是否注定将扮演越来越重要的角色?

答:对于“计算机学者中少有的有着深厚文化底蕴的老师”之类的说法,实不敢当。其实,我对文化或者人文的了解只是停留在感兴趣的阶段,远谈不上有什么深度。计算机科学的发展日新月异,新思想、新算法、新技术层出不穷,需要时刻通过学习来不断更新自己,同时研究任务也很繁重,每天应付这些,已然精疲力竭。最近若干年,我用于阅读人文图书的“常规时段”通常有两个:一是如厕时;二是上床睡觉前。还有一个就是坐飞机时坚持不看专业图书,而是浏览一些报纸杂志之类。我的主要精力都集中于计算机主业上,对人文知识的学习与跟进仅此而已。

从根本上说,计算机科学同数学之间的关系最为密切,计算机科学的大师级人物多是数学出身,数学造诣都很精深。计算机科学与人文科学在学理上并没有太直接的关系(当然也不能一概而论,如世界级语言学大师乔姆斯基提出“乔姆斯基形式文法体系”以及与上下文无关文法相关的“乔姆斯基范式”,就对计算机科学产生了深远影响)。从这个角度来看,“人文底蕴”对计算机科学整体上貌似帮助不大。

随着人工智能的蓬勃发展,上述情形正在发生一些变化。变化主要反映在两个层次上,一个是人工智能原创理论层次,需要具有顶级数学功底的计算机科学家同神经和认知顶级科学家通力合作,以期对计算机科学领域产生变革性的影响;另一个是人工智能应用层次,也就是所谓的“人工智能+X”,需要计算机领域的优秀学者同其他学科领域的优秀学者通力合作,以期对其他学科领域产生变革性的影响。这两种跨界合作将注定扮演越来越重要的角色。

我从小就对人文,尤其是中国古代文化和历史感兴趣。这一点对我在三十年前选择自然语言处理这个专业方向上确实发挥了至关重要的作用,也是我这些年来比较喜欢从事与人文乃至社会科学大跨度交叉研究的源泉所在。

问:您担任首席科学家的973项目“面向三元空间的互联网中文信息处理理论与方法”中,把人类认知空间、网络空间和现实世界空间一起统称为“三元空间”,这背后的逻辑是什么?这个雄心勃勃的973项目希望在融合“三元空间”的海量知识获取与组织、大规模中文深度分析与内容理解方面有所突破,目前取得了哪些重要进展?这些进展对于我国在中文信息处理领域的发展及社会化智能信息服务的提升方面有什么重要意义?

答:实际上,“三元空间”是973指南里的要求,对其内涵存在着若干种解读可能性。我在申请项目时,针对语言信息处理的特点,把“三元空间”定义为网络空间、现实世界和人类认知。以人类语言为纽带,把如上定义的“三元空间”联系到一起,其背后的逻辑是不言而喻的。

经过5年的不懈努力,这个项目取得了显著进展,完全实现了预期目标。简而言之,其标志性成果有三:一是提出了融合大规模知识的中文语义表示学习方法体系,努力将中文各个语言层次,即字、词、词义、语、句等形式化地表示在一个统一的计算框架中;二是提出了语义驱动的中文语义依存分析算法,将中文在这方面的自动分析能力提升到了与英文相当的水平;三是建立了世界上规模最大的中文语言知识资源和中文知识图谱。这些进展对于我国在中文信息处理研究领域的发展以及社会化智能信息服务的提升方面,起到了积极的推动作用。

(图片来自网络)

问:《未来简史》的作者尤瓦尔·赫拉利(Yuval Noah Harari)认为,工业时代普通民众因为担纲社会的主要劳动力和战时兵力,“无论哪种政体的国家,都极为重视国民的健康、教育和福利,因为它们需要几百万健康的劳动者在生产线工作,需要几百万忠诚的士兵在战壕里作战”,因此,20世纪有一大部分时间是在缩小阶级、种族和性别之间的不平等。但人工智能的兴起可能会让大多数人不再拥有经济价值和政治力量。同时,生物技术的进步则可能将经济上的不平等转化为生物体上的不平等,即富人和知识精英具有更多机会强化自己的生物机能乃至脑力和智慧,马太效应成为一种社会自然演变之后的主导机制。他由此预言,21世纪的人类社会可能会是人类历史上最不平等的社会,人类整体出现生物种姓并非不可能。您如何看待人工智能和生物技术发展对人类社会结构形态带来的长远影响?

答:对上述观点,如“人工智能的兴起可能会让大多数人不再拥有经济价值和政治力量”,“21世纪的人类社会可能会是人类历史上最不平等的社会”等,我完全没有研究,很难做出评论。我个人认为,互联网时代具有双重性,双面重要作用都不容小觑:一是使得世界日益成为平的;二是马太效应确实在不断增强,这又使得差异日益扩大。我们有必要对这一深刻的矛盾予以足够关切。

总体来看,人工智能技术还处于初级发展阶段。目前这一代人工智能技术是以借重于大数据的深度学习算法为核心的,在围棋、图像识别、语音识别、机器翻译等人工智能经典任务上确实表现出了异乎以往的能力,催生了如雨后春笋般勃兴的人工智能创新企业,但是,其适用范围实际上存在着严重局限。它的现有能力被大大高估了,领域内的专家反倒比较谨慎。那么,人工智能对人类社会结构形态会带来怎样的变化呢?由于目前这一代人工智能技术的“本事”还十分有限,所以其短期影响虽然十分明显,会给人以“横扫千军如卷席”之感,但总体上看其影响应该还是局部性的,而不是全局性的。至于其长远影响,现在还说不准,取决于人工智能理论和方法是否有新的实质性突破。这种突破的可能性,现在看来尚属可望而不可及。

问:自动驾驶一度成为近年来令人瞩目的热点,不少公众对之充满期待。鉴于驾驶任务本身对行动者和环境互动的极高要求,自动驾驶一直被看作是衡量人工智能发展水平的重要标尺之一。国内外尖端技术公司如百度和Google都在大力研发自动驾驶。不少公司甚至把2019年作为全自动驾驶汽车投入运营的关键年。但最近,自动驾驶领头羊Waymo掌门人John Krafcik承认,自动驾驶汽车在路上普及还要几十年;苹果联合创始人Steve Wozniak也认为,自动驾驶汽车不可能在不久的将来实现。这其中的一个原因是,自动驾驶的场景太多元太复杂,算法达不到要求,即自动驾驶技术还没有达到在任何天气和任何条件下都能驾驶的最高等级L5。您如何看待诸如自动驾驶这样将深刻影响人们生活方式的智能技术和产品的发展前景?在自动驾驶情景下,我们将根据什么原则来认定可能发生的交通事故的责任主体?

答:近年来,我在几个公开学术报告中都提及过,完全意义的自动驾驶无法在不远的将来实现。根本原因在于当前这一代人工智能技术的“本事”还十分有限。正如清华大学人工智能研究院院长张钹院士很早前敏锐指出的那样:它(人工智能)能做得比人好的任务场景,必须满足一些重要的性质(为了下文表述方便,不妨称之为“目前人工智能技术的若干适用性质”),如:任务的边界是确定的;任务的解空间是有限的、可预期的(即使空间无比巨大);执行任务的规则是明确的;任务执行过程中的信息是完全的;对任务结果的最终得失评估也是可精确量化的。其中任意一条不满足,现有的人工智能技术就会遭遇很大的困扰。充足的大数据可以在相当程度上克服这些困扰,但其性能会大打折扣,通常不可能做得比人好(但在某些应用场景下,做得比人的平均水平好并不困难)。围棋满足上述所有性质,所以人工智能的性能超越了人类棋手。自动驾驶基本上都不满足上述性质,并且属于所谓的“生死攸关”任务,几乎不容许犯任何错误(人类对机器性能的可靠性要求往往比对人的要求更为严苛),这是当前人工智能技术的“阿喀琉斯之踵”,所以我才有如上判断。当然这并不否定自动驾驶在特定受限场景中仍然会有广泛应用的前景。

需要特别强调的一点是,作为人工智能的基本前沿课题之一,对自动驾驶的基础性研究需要进一步强化和深化。什么时候才可能有完全意义的自动驾驶?还是前面那句话,取决于人工智能理论和方法是否有新的实质性突破。对自动驾驶各种关键问题的深入探索将成为下一代人工智能理论和方法发展的一个重要推动力和试金石。

问:关于智能内容生产。在新闻传播领域,人工智能的发展正在深刻改变这个以生产新闻和各种内容为主的行业的生态。在诸如气象、环保、体育、财经等领域的报道中,机器新闻写作,至少是机器辅助写作(robot-aided writing),已然在世界各大通讯社的新闻生产和各种商业机构的公关写作中得以试水和推行。在刚刚结束的乌镇世界互联网大会上,毕业自贵系的搜狗公司CEO王小川与新华社副社长刘思扬联合携“一位”人工智能合成主播惊艳亮相,引发广泛关注。您如何看待人工智能对写作、创作、表演这些传统意义上人类所独有行为和能力所带来的影响?如何看待人工智能将对创意产业和内容生产行业可能带来的深远影响?一个国家的社会文化景观将因此发生怎样的变化?

答:受囿于我前面所说的当前人工智能技术的局限性(“目前人工智能技术的若干适用性质”),人工智能在新闻传播领域的应用范围和程度一定是局部的、有限的,不会导致全局性质变。机器自动新闻写作只是在由数据表格生成文本这个受限任务中取得了不错的效果。但要像高水平的记者一样写出有深度的新闻及评介,在可预见的将来,机器还做不到(借助机器辅助写作是另外一回事)。人工智能播音这一任务比自动写作简单得多,但要超越人类顶尖主播,也不太可能。

不过,人工智能辅助写作、创作、表演,辅助创意产业和内容生产,以一种人机协同的方式大幅提高工作效率和质量,是完全具备现实性的,会给相关行业(尤其是中低端行业)带来广泛影响。

问:关于算法与用户内容消费。近年来,借助于大数据和云计算的不断改进升级,各种内容算法推荐——主要是基于用户过往消费行为和基于用户社交关系网中其他人的消费偏好进行的内容和商品推荐——席卷各种内容、购物和社交平台。基于用户行为、场景特点、社交圈结构的算法推荐一方面因其精准传播(precision messaging),实现对用户需求和偏好的深刻洞察而备受平台、商家和用户青睐,但另一方面,算法推荐所导致的“茧房”(information cocoons)效应,又容易让人们耽于既有审美、关注点、品位乃至视野之囿而不自知,不仅心智成长和审美拓展会受到影响,更容易造成同辈抱团、对他群声音充耳不闻的“回音壁效应”(echo chamber effect),甚至会加剧社会民众的阶层分化并导致社会撕裂。作为一名人工智能领域前沿专家,您认为智能算法推荐是否会对普通民众信息、内容消费方式带来深层次、结构性影响?这种影响主要表现在哪些方面?

答:内容算法推荐并不完全满足“目前人工智能技术的若干适用性质”,但由于此类平台天然拥有大数据(特别是用户行为数据),也不属于“生死攸关”的任务,所以比较适合人工智能,能够实现用户还算满意的个性化推荐效果,这一点不足为奇(何况人去做这件事也不是很有理据的,带有很强的主观性);通过进一步改进算法增加推荐的多样性,有效应对“茧房效应”和“回音壁效应”,也是可以预期的。

人们对智能算法推荐表现出足够关切是完全必要的,也是完全可以理解的。例如,平台出于自身利益的考量,算法推荐可能会出现广泛性偏误,或者过度推荐。所发生的这些现象,有些是目前智能推荐算法一时难以克服的深刻困难(涉及语义理解这一难点)所致,有些则是可能是有意为之。

马歇尔·麦克卢汉 (图片来自网络)

问:让我们来展望一下社会计算的极限问题。您是否同意这样的看法,即人工智能的上限本质上取决于社会计算的计算能力?无论是情感还是价值判断,无论是艺术创意还是审美趣味,无论是解释还是推理,一切人之为人的特质,是否最终都能够被“计算能力”一一解析并复盘?在前不久的一次采访中,您提到目前人工智能总体上依旧处于无理解的人工智能阶段,下一个挑战是有理解能力的人工智能,要想实现“有理解力”还很难。在无理解的人工智能和有理解的人工智能之间,在计算的此岸和生命的彼岸之间,注定是深不见底无可逾越的鸿沟——如0和1之间的差别——还是其实最终有什么桥梁可以跨越和架接,也即借助于不断累积的计算能力和模型改进,以及实时数据采集反馈系统的改进,在物质和意识之间终究可以曲径通幽,加以打通?

答:我第一次听到“人工智能的上限本质上取决于社会计算的计算能力”这个表述,不很清楚其含义,难以评论。是的,现在看到的人工智能所取得的成功,大都属于无理解的人工智能。此类算法本质上都是针对某一特定任务,从相关大数据中学习一个高度复杂的非线性函数,而这个函数可以看作是一个“黑箱”,缺乏可解释性。接下来的重大挑战是解决有理解的人工智能问题,让机器具有同人一样的感知和认知能力、推理能力、判断和决策能力。无理解的人工智能和有理解的人工智能两者之间存在本质上的深刻差异,因而跨越起来极其困难。再强大的计算能力也解决不了这个问题,反之,我们需要人工智能算法在思想和理论上的深刻创新,其中的关键桥梁之一就是人类语言理解。语言是人类区别于动物的唯一标志。机器对语言不能理解,很难说有比较高级的智能。而语言理解的边界是完全开放的,所以非常具有挑战性。机器要在物质和意识、思维之间自由地腾挪辗转,必须首先打通语言理解这一关,否则根本谈不上“曲径通幽”。

问:预言了地球村的媒介学者马歇尔·麦克卢汉(Marshall McLuhan)曾经形象地把媒介称为“人的延伸”。事实上,随着生物技术特别是脑科学领域的研究突破,从智能芯片的人体植入到未来人机不同比例的混搭,麦克卢汉所谓的“媒介是人的延伸”的论述将很有可能从比喻演变为现实。您如何看待人工智能技术对人体先赋能力的后天补强?这种嫁接了人工智能的“超自然”人类改良技术的出现和应用,会带来怎样的社会和伦理后果?就像爱因斯坦作为质能方程的提出者为原子核聚变反应奠定理论基础,却为核武器的出现而感到惴惴不安一样,您觉得如今人工智能领域的科学突破,是否也应该对技术的社会伦理后果有更多的自觉?

答:我基本赞成“媒介是人的延伸”这个说法。其实飞机、轮船等就是人的体力延伸,人工智能则是人的智力延伸,两者的目的都是为了帮助人,也就是你在提问中所说的对人体先赋能力不足的后天补强。单纯使用目前的人工智能技术应该还不致带来严重的社会和伦理后果,不必过于不安——那将是下一代人工智能必须关切的,且无法回避的问题。然而,人机混搭的智能正在日益朝现实迈进,在发展过程中无疑会产生以前没有遇到过的社会和伦理问题,必须加强相关研究,特别是对什么是禁区要做到心中有数,进而达到趋利避害。

问:基特勒(Fredirch Kittler)认为,数字媒介的硬件和软件都具有隐蔽性。在软件的遮蔽下,用户看不到自己受到了硬件的限制;而软件虽然使得用户可以与计算机进行互动交流,但用户却常常感觉不到其背后的结构和逻辑乃至所内嵌的价值观偏向对自己行为和世界观造成的潜移默化的规制、影响和形塑。这也正是劳伦斯·莱斯格(Lawrence Lessig)在其著名的《代码》(Code)一书中所表达的担忧。您如何看待代码所构建的“系统”——这双“看不见的手”对用户和民众的控制能力乃至权力主导?更有甚者,当基于代码的系统具备了深度学习的能力,结合海量的动态语料和分布式计算的迭代升级,我们现在衣食住行日益依赖的不少系统,是否最终会成为具有一定自在性和自主性的行为和责任主体,或至少是和平台拥有方、开发者并置的责任主体?

答:实际上,现代社会经济生活中存在着形形色色的“看不见的手”,我们或多或少地受到其操纵而不能自拔。代码所构建的“系统”借重于算法和大数据的强大力量也具有这一特点,这本身没有什么可奇怪的。需要关切的是,我们应对此类控制力乃至权力主导保持足够的警惕,不能在无意识中一味地被“系统”背后的小团体利益所裹挟。

问:最后还是回到您和您团队的研究,来聊聊“诗和远方”。您的实验室开发机器诗人“九歌”,与您平时爱吟诗作词不无关联吧?2017年,“九歌”亮相央视《机智过人》节目,按照比赛规则接受图灵测试,九歌以一首“机心造化本无私,智略工夫巧笑时。过客不须频眺处,人间天上有新诗”顺利通过图灵测试,展现了很高程度的“智能”水平?您怎么看待和评价九歌真实的智能水平?您曾经说过“计算机作诗在科学研究上很有意义”,为什么?

答:必须澄清一点:以一首诗的结果,绝对不能说“九歌” (https://jiuge.thunlp.cn)通过了图灵测试。必须通过大量的实际测试,才敢在古诗创作是否通过图灵测试这一点上给出结论,现在还远不敢说。我感觉,当下“九歌”的真实智能水平只能达到古诗爱好者人群(包括诗人)内的中上水平。自动作诗这个任务在好几项上都不满足“目前人工智能技术的若干适用性质”(例如,对自动作诗结果优劣的评价见仁见智,并不存在绝对标准),因此是非常困难的问题,其本质上不可能超越顶尖诗人。正因为其困难,所以与之相关的研究对探索下一代人工智能很有意义。

我领导的实验室研发机器诗人“九歌”,与我以及主创人员之一,也是我的学生矣晓沅喜欢古典诗词不无关联。我们的初心是探索人工智能在自由式文本生成这一类问题(而不是由数据表格生成新闻文本的那类问题)上的算法解决方案。同围棋类似,古典诗歌的开拓空间也是非常广袤的,古人只是创作出了其中微乎其微的一小部分,绝大部分空间还有待于我们去发现。怎样去发现呢?我们希望利用人工智能算法,基于已知的古人诗歌创作对浩瀚的未知空间进行合理的推衍,期待能达到的效果是利用机器把古人尚未来得及写出的诗“挖掘”出来,大底上就是陆游所说的“文章本天成,妙手偶得之”的意思。此外,古诗创作带有强烈的传统文化色彩,容易引起公众的关注,进而会给予我们的研究以某种无形压力,鞭策我们不断地改进算法、提升性能。这也是我们选择以这个问题作为算法攻关任务的原因之一。当然,自动作诗只是我领导的实验室中众多人工智能研究方向的一支。

“原文刊载于《全球传媒学刊》2018年第4期。

编辑:冉玲琳 |

作者: admin 时间: 2019-1-19 22:03

【案例】

眼见不再为实|【外交事务】:照片可P,视频可P,直播也可P

【世界决定视界】【视界决定世界】

欢迎打开“我与我们的世界”,从此,让我们一起纵览世界之风云变幻、洞察社会之脉搏律动、感受个体之生活命运、挖掘自然之点滴奥妙。

我与我们的世界,既是一个奋斗的世界,也是一个思考的世界。奋而不思则罔,思而不奋则殆。这个世界,你大,它就大;你小,它就小。

欢迎通过上方公众号名称,来挖掘本公众号与大家共享的往期文章,因为,每期都能让你“走近”不一样的世界、带给你不一样的精彩。

本期导读:人脸解锁、刷脸购物、人脸识别的动物表情小游戏,生活中已很常见,这在一定程度上也就说明了一个问题,那就是,人工智能(Artificial Intelligence)在人脸这件事儿上已经越来越精通了。

如果说识别只是AI对人脸做出的第一件事,那么第二件事是什么呢?从种种迹象来看,答案只有一个,那就是给人换脸。当然,AI不会真的去给人整容(至少目前不会),它能做的是在视频里给人换脸。比如曾被刷屏的小视频可能有些朋友就已看过。

视频中的女主角(确切的说是女主角的脸)是《神奇女侠》的扮演者盖尔·加朵。但这当然不是其本人出演了什么令人羞耻的小电影。而是有人用深度学习(Deep Learning)技术把盖尔·加朵的脸替换到了原片女主角的身体上。

这就是源自2017 年 12 月,一位自稱 DeepFakes 的網友利用深度學習技術,將 A 片女主角換臉成神力女超人女主角蓋兒加朵(Gal Gadot),此技術當時引起一陣轟動,近日有外國的研究報告估計,DeepFakes將會成為對下屆美國總統大選構成影響,甚至造成威脅的人工智能技術。

根據《The Nextweb》報導,研究人員認為只要依賴人工智慧,加上事先蒐集大量的語音訓練數據,就可以製造出以假亂真語音記錄和影片,預計在 5 年內,這項技術將會越來越成熟,足以欺騙沒有訓練過的人們。

隨著人工智慧(AI)技術日漸成熟,民眾越來越難分辨網路上假新聞及假影片的真實性。就像是之前美國男演員喬登皮爾(Jordan Peele)和美國數位新聞網站 BuzzFeed,就利用前陣子火紅的 AI 換臉技術「FakeApp」,聯合製作一條歐巴馬談論假新聞的政令宣傳影片,逼真到讓人難以分辨。

视频截图

根據《The Verge》報導,這隻影片除了採用之前美國網友 Deepfakes 所使用的 AI 人臉交換技術「FakeApp」外,也有使用 Adobe 的視覺特效製作軟體After Effects,兩個軟體一起結合運用,成功地用歐巴馬的臉把喬登皮爾的臉換掉。

AI人工智能在全球开花,而这个技术也是被运用到各行业中来。据CNET报道称,Naughty America公司打算通过AI人工智能,为用户提供定制化的换脸视频,当然主要是集中在一些成人电影上,而这种人工智能驱动的换脸技术掀起了行业的热潮。

据悉,Naughty America正在使用的AI技术,可以做的不仅仅是替换面容。用户可以和他们最喜欢的女演员或男演员一起出现在一个场景中,或者可以把自己置身于现实生活中不可能的性环境中,甚至情侣也可以一起放到同一场景中。

目前Naughty America团队将与外部人工智能研究人员合作制作这类视频,不过国外的一些社交网站已经禁止换脸色情视频。美国国防高级研究计划局(DARPA)正在研究一种检测深度伪造视频的方法。

这个ID叫做DeepFakes的网友,始终致力于在Reddit上分享其利用AI技术制作的明星换脸小视频。差不多所有当红的好莱坞女星都被他“炮制”了一遍。各位是不是感觉有点兴奋?以后想看哪位明星的片子自己动手做就是了,甚至可以把自己的脸替换上去演对手戏,各种YY皆能成真。

可是,如果是你亲戚朋友的脸被替换了呢?如果把犯罪现场所拍摄嫌疑人的脸换成你呢?如果在你不知情的情况下,不法分子发给你家人一段有你露脸的绑架视频呢?当我们不能相信自己的眼睛,各种混乱和罪恶的重量,绝对会大于那一点点违法的“福利”。

换脸的恐怖之处,在于AI很简单。

回到前面提到制作女星换脸小电影的DeepFakes。这哥们不仅是个老司机,还是一位热爱分享的“技术型活雷锋”,不仅免费发布他的成果,还不厌其烦的分享自己制作换脸视频的教程,以及自己编写的深度学习代码和相关数据集。大概他的意思是,别再问我要谁谁的视频了,你们自己做去吧。

当然,这哥们也不是专注女明星,上边这张就是他分享的如何把尼古拉斯·凯奇换成川普的教程。根据他的分享,制作一个明星换脸视频非常简单。以盖尔·加朵的视频为例,他首先会在谷歌、YouTube以及各种网络图集中收集盖尔·加朵的各个角度的视频和图片。组成一个能满足深度学习任务进行脸部替换的素材库。

然后通过TensorFlow上提供的机器视觉相关模型,学习和理解原版小电影中女主角的面部特征、轮廓、动作和嘴型等。继而让模型在素材库中寻找各种角度、各种表情下AI认为合适的图片与视频,对原本视频进行替换。

虽然可以看到,他做的视频在很多细节上还是有瑕疵,不够自然。但是大体一看已经可以蒙混过关,并且制作效果在日渐提高。这里隐藏的真正问题,在于利用开源的AI架构进行视频换脸这件事,不是太复杂太前卫了,而是太简单太容易了!

这东西毫无技术难度,要会用TensorFlow的基础功能,电脑显卡不至于太烂,差不多几个小时就可以搞出来一个。哪怕连编程基础都没有的人,跟着教程一步步走,搜集足够多的素材,也可以自己搞出来换脸视频。

设想一下,当你身边某个仇人想要陷害你的时候,只要收集你的照片和自拍,就可以随意把你和任何罪恶甚至肮脏的视频结合到一起,然后在你的社交圈里散播的到处都是,那场面何其令人胆寒?这就像枪支可以无审查、无监管的随意买卖,并且价格低廉。

在机器视觉开发的底层技术日益完善后,视频换脸必然继续在三个层面加强它的普及化:

1.近乎无门槛使用。换脸相关的数据集、源代码和架构,在今天只要有心就可以轻易找到,随着技术的成熟,这种趋势大概只会愈演愈烈。

2.可以工具化。由于技术并不复杂,这个功能被工具化的可能性很大。也就是说不法分子可以把它做成一个应用,购买了之后只要按要求添加视频和希望替换人的图像,就可以自动生成换脸视频,达成真正的无门槛。

3.欺骗性不断增强:有相关AI从业者认为,DeepFakes的视频仅仅经历了初步的学习和替换过程,没有进行修补和细节雕琢,就已经获得了很高的完成度。那么假如进一步结合对抗生成网络进行修饰,大概就可以生成真伪难辨的视频了。

总之,当我们知道照片可以PS之后,视频也不再可信了。而且,不仅仅是视频。

山雨欲来:下一站是直播+换脸

去年年初的时候,德国纽伦堡大学的相关团队发布了一个应用,也就是非常出名的Face2Face。这款应用的能力,是通过摄像头进行脸部追踪,从而让视频里的人跟着你说话。

由于其精准的捕捉效果和实时化能力,Face2Face在诞生之日起就引起了轩然大波。在其演示视频下,无数网友质疑这项技术将成为网络诈骗、绑架勒索的帮凶,质疑如果视频电话的另一端,竟然不是你认识的那个人,那将会是多么恐怖的一件事。

当然,Face2Face目前是个封闭状态,用户只能扮演其提供的角色尝尝鲜而已。但经过一年多的发展,直播中的脸部捕捉和替换技术也已大幅度提升。如今我们可以在直播平台上看到实时替换的背景和道具,而利用AI在直播中进行脸部替换,也已经是近在咫尺的事了。

与之相配合的,是AI进行声纹识别与声音合成技术也在突飞猛进。比如Adobe在近两年陆续发布了新的声音合成技术。普通人用AI来进行柯南用蝴蝶结完成的换声,已经不是多困难的事情。

借助AI,直播中换脸和换声正在同步向前跨越。那么带来的影响会是什么呢?双头人开播?川普坐在白宫办公室里跟你连麦?某当红小鲜肉在直播中跪着给你唱《征服》?没问题,统统都可以。有没有很开心?当然,你跟直播平台可能都开心了,小鲜肉却不开心了。

而换个角度想想,假如同样的技术运用在视频电话里呢?假如你接到的亲人/朋友的视频电话,套取你的隐私或者跟你借钱,事后竟然发现是陌生人处心积虑伪造的。假如一个人可以彻底伪装成另一个人,还会有人开心吗?

当我们打开手机电脑,发现一切都不是真的。真是挺让人丧心病狂的一件事。

AI换脸并不难,由于多种应用场景的存在和超高的娱乐性,我们也很难阻止它的到来。于是真正该让我们头疼的,大概就是深藏其中的法律问题与伦理陷阱。

基本可以很靠谱的说,今天国内外的很多直播与视频平台,都在研发直播换脸技术。并且某些解决方案已经相当成熟。试想一下,换脸之后的当红女神与小鲜肉,整晚开直播说一些迎合猎奇心理的话,礼物还不多到把平台挤爆了?——即使用户明知是假的。

当然,正规直播平台大概不敢这么做,使用这种技术会非常克制。但是假如有第三方插件可以做这件事呢?或者在缺乏监管的地下直播/半地下直播平台上呢?毕竟利益和猎奇可以驱使人去做各种事情,技术的门槛一旦解禁,滚滚而来的法律问题很可能决堤。

这里隐藏的伦理陷阱,是肖像权这个东西可能会前所未有的复杂化。无论是明星还是普通人,大概都不希望被别人“易容”成自己的样子来进行直播。

但问题是,你如何证明易容的是你呢?或者说你如何证明你是你?我们知道,肖像权是指你本人拍摄的图像和视频。但是用你的面部数据搭建起来的AI模型还属于你的肖像权范畴吗?

更困难的是,你根本无从证明AI搭建出来的肖像模型跟你有直接关系。毕竟深度学习训练是在看不见的后端完成的,制作者大可以说是臆想出来,或者用跟你很像的人来搭建的。再或者只比你脸上多一颗痣,是不是就不是你了呢?

更复杂的伦理情况还有很多,比如一个人享有故去亲人的肖像权吗?假如一个人希望用AI来重现已故的亲属,与亡者进行视频通话,但另一个亲属却坚决认为这是违法行为,那么到底该听谁的?

这还是基础的伦理与法律矛盾,在这之外,是大把可以用AI换脸术进行的非法勾当。比如诈骗、勒索、诬陷等等等等。总而言之,AI换脸术这件事在今天可以归纳为三句话:一、火是肯定要火的;二、乱是一定要乱的;三、如何监管,大概是不知道的。

哦对了,最后应该说一下如何防止别人做出你的AI换脸视频:不要发太多自拍。

Deepfakes and the New Disinformation War: The Coming Age of Post-Truth Geopolitics

深度换脸技术与新型虚假信息战争:后真相地缘政治时代来临

By Robert Chesney and Danielle Citron

小编注:译文部分仅供参考;本期共享文章摘自“外交事务”网站,文章有点小长,也有点小难,因此搜了好多相关信息,整理出上面那篇较长的导读;本公众号更多优质文章,见文末“往期精彩”。

A picture may be worth a thousand words, but there is nothing that persuades quite like an audio or video recording of an event. At a time when partisans can barely agree on facts, such persuasiveness might seem as if it could bring a welcome clarity. Audio and video recordings allow people to become firsthand witnesses of an event, sparing them the need to decide whether to trust someone else’s account of it. And thanks to smartphones, which make it easy to capture audio and video content, and social media platforms, which allow that content to be shared and consumed, people today can rely on their own eyes and ears to an unprecedented degree.

与文字比起来,照片更具直观性。远比照片更具直观性的,则是音视频。现如今这个信息时代,人们通过眼睛耳朵所能接触到的音视频信息数量之巨,前所未有。

Therein lies a great danger. Imagine a video depicting the Israeli prime minister in private conversation with a colleague, seemingly revealing a plan to carry out a series of political assassinations in Tehran. Or an audio clip of Iranian officials planning a covert operation to kill Sunni leaders in a particular province of Iraq. Or a video showing an American general in Afghanistan burning a Koran. In a world already primed for violence, such recordings would have a powerful potential for incitement. Now imagine that these recordings could be faked using tools available to almost anyone with a laptop and access to the Internet—and that the resulting fakes are so convincing that they are impossible to distinguish from the real thing.

有很多影音视频,可以是假的。

Advances in digital technology could soon make this nightmare a reality. Thanks to the rise of “deepfakes”—highly realistic and difficult-to-detect digital manipulations of audio or video—it is becoming easier than ever to portray someone saying or doing something he or she never said or did. Worse, the means to create deepfakes are likely to proliferate quickly, producing an ever-widening circle of actors capable of deploying them for political purposes. Disinformation is an ancient art, of course, and one with a renewed relevance today. But as deepfake technology develops and spreads, the current disinformation wars may soon look like the propaganda equivalent of the era of swords and shields.

技术的进步,也带来了虚假信息的泛滥。

DAWN OF THE DEEPFAKES

深度换脸技术时代来临

Deepfakes are the product of recent advances in a form of artificial intelligence known as “deep learning,” in which sets of algorithms called “neural networks” learn to infer rules and replicate patterns by sifting through large data sets. (Google, for instance, has used this technique to develop powerful image-classification algorithms for its search engine.) Deepfakes emerge from a specific type of deep learning in which pairs of algorithms are pitted against each other in “generative adversarial networks,” or GANS. In a GAN, one algorithm, the “generator,” creates content modeled on source data (for instance, making artificial images of cats from a database of real cat pictures), while a second algorithm, the “discriminator,” tries to spot the artificial content (pick out the fake cat images). Since each algorithm is constantly training against the other, such pairings can lead to rapid improvement, allowing GANS to produce highly realistic yet fake audio and video content.

通过生成式对抗网络技术,可做出极其逼真但实际上却是虚假的影音视频。

小编注:生成式对抗网络(GAN, Generative Adversarial Networks )是一种深度学习模型,是近年来复杂分布上无监督学习最具前景的方法之一。模型通过框架中(至少)两个模块:生成模型(Generative Model)和判别模型(Discriminative Model)的互相博弈学习产生相当好的输出。该方法由伊恩·古德费洛等人于2014年提出。生成网络从潜在空间(latent space)中随机采样作为输入,其输出结果需要尽量模仿训练集中的真实样本。判别网络的输入则为真实样本或生成网络的输出,其目的是将生成网络的输出从真实样本中尽可能分辨出来。而生成网络则要尽可能地欺骗判别网络。两个网络相互对抗、不断调整参数,最终目的是使判别网络无法判断生成网络的输出结果是否真实。生成对抗网络常用于生成以假乱真的图片。此外,该方法还被用于生成视频、三维物体模型等。

This technology has the potential to proliferate widely. Commercial and even free deepfake services have already appeared in the open market, and versions with alarmingly few safeguards are likely to emerge on the black market. The spread of these services will lower the barriers to entry, meaning that soon, the only practical constraint on one’s ability to produce a deepfake will be access to training materials—that is, audio and video of the person to be modeled—to feed the GAN. The capacity to create professional-grade forgeries will come within reach of nearly anyone with sufficient interest and the knowledge of where to go for help.

技术很容易获得,唯一的约束性条件就是控制“训练材料”的获得。

Deepfakes have a number of worthy applications. Modified audio or video of a historical figure, for example, could be created for the purpose of educating children. One company even claims that it can use the technology to restore speech to individuals who have lost their voice to disease. But deepfakes can and will be used for darker purposes, as well. Users have already employed deepfake technology to insert people’s faces into pornography without their consent or knowledge, and the growing ease of making fake audio and video content will create ample opportunities for blackmail, intimidation, and sabotage. The most frightening applications of deepfake technology, however, may well be in the realms of politics and international affairs. There, deepfakes may be used to create unusually effective lies capable of inciting violence, discrediting leaders and institutions, or even tipping elections.

对很多领域来说,这项技术具有很大应用价值。但技术是把双刃剑,技术能应用于善,也能应用于恶。

Deepfakes have the potential to be especially destructive because they are arriving at a time when it already is becoming harder to separate fact from fiction. For much of the twentieth century, magazines, newspapers, and television broadcasters managed the flow of information to the public. Journalists established rigorous professional standards to control the quality of news, and the relatively small number of mass media outlets meant that only a limited number of individuals and organizations could distribute information widely. Over the last decade, however, more and more people have begun to get their information from social media platforms, such as Facebook and Twitter, which depend on a vast array of users to generate relatively unfiltered content. Users tend to curate their experiences so that they mostly encounter perspectives they already agree with (a tendency heightened by the platforms’ algorithms), turning their social media feeds into echo chambers. These platforms are also susceptible to so-called information cascades, whereby people pass along information shared by others without bothering to check if it is true, making it appear more credible in the process. The end result is that falsehoods can spread faster than ever before.

These dynamics will make social media fertile ground for circulating deepfakes, with potentially explosive implications for politics. Russia’s attempt to influence the 2016 U.S. presidential election—spreading divisive and politically inflammatory messages on Facebook and Twitter—already demonstrated how easily disinformation can be injected into the social media bloodstream. The deepfakes of tomorrow will be more vivid and realistic and thus more shareable than the fake news of 2016. And because people are especially prone to sharing negative and novel information, the more salacious the deepfakes, the better.

DEMOCRATIZING FRAUD

民主幻像

The use of fraud, forgery, and other forms of deception to influence politics is nothing new, of course. When the USS Maine exploded in Havana Harbor in 1898, American tabloids used misleading accounts of the incident to incite the public toward war with Spain. The anti-Semitic tract Protocols of the Elders of Zion, which described a fictional Jewish conspiracy, circulated widely during the first half of the twentieth century. More recently, technologies such as Photoshop have made doctoring images as easy as forging text. What makes deepfakes unprecedented is their combination of quality, applicability to persuasive formats such as audio and video, and resistance to detection. And as deepfake technology spreads, an ever-increasing number of actors will be able to convincingly manipulate audio and video content in a way that once was restricted to Hollywood studios or the most well-funded intelligence agencies.

Deepfakes will be particularly useful to nonstate actors, such as insurgent groups and terrorist organizations, which have historically lacked the resources to make and disseminate fraudulent yet credible audio or video content. These groups will be able to depict their adversaries—including government officials—spouting inflammatory words or engaging in provocative actions, with the specific content carefully chosen to maximize the galvanizing impact on their target audiences. An affiliate of the Islamic State (or ISIS), for instance, could create a video depicting a U.S. soldier shooting civilians or discussing a plan to bomb a mosque, thereby aiding the terrorist group’s recruitment. Such videos will be especially difficult to debunk in cases where the target audience already distrusts the person shown in the deepfake. States can and no doubt will make parallel use of deepfakes to undermine their nonstate opponents.

Deepfakes will also exacerbate the disinformation wars that increasingly disrupt domestic politics in the United States and elsewhere. In 2016, Russia’s state-sponsored disinformation operations were remarkably successful in deepening existing social cleavages in the United States. To cite just one example, fake Russian accounts on social media claiming to be affiliated with the Black Lives Matter movement shared inflammatory content purposely designed to stoke racial tensions. Next time, instead of tweets and Facebook posts, such disinformation could come in the form of a fake video of a white police officer shouting racial slurs or a Black Lives Matter activist calling for violence.

Perhaps the most acute threat associated with deepfakes is the possibility that a well-timed forgery could tip an election. In May 2017, Moscow attempted something along these lines. On the eve of the French election, Russian hackers tried to undermine the presidential campaign of Emmanuel Macron by releasing a cache of stolen documents, many of them doctored. That effort failed for a number of reasons, including the relatively boring nature of the documents and the effects of a French media law that prohibits election coverage in the 44 hours immediately before a vote. But in most countries, most of the time, there is no media blackout, and the nature of deepfakes means that damaging content can be guaranteed to be salacious or worse. A convincing video in which Macron appeared to admit to corruption, released on social media only 24 hours before the election, could have spread like wildfire and proved impossible to debunk in time.

Deepfakes may also erode democracy in other, less direct ways. The problem is not just that deepfakes can be used to stoke social and ideological divisions. They can create a “liar’s dividend”: as people become more aware of the existence of deepfakes, public figures caught in genuine recordings of misbehavior will find it easier to cast doubt on the evidence against them. (If deepfakes were prevalent during the 2016 U.S. presidential election, imagine how much easier it would have been for Donald Trump to have disputed the authenticity of the infamous audio tape in which he brags about groping women.) More broadly, as the public becomes sensitized to the threat of deepfakes, it may become less inclined to trust news in general. And journalists, for their part, may become more wary about relying on, let alone publishing, audio or video of fast-breaking events for fear that the evidence will turn out to have been faked.

DEEP FIX

深度技术需深度应付

There is no silver bullet for countering deepfakes. There are several legal and technological approaches—some already existing, others likely to emerge—that can help mitigate the threat. But none will overcome the problem altogether. Instead of full solutions, the rise of deepfakes calls for resilience.

Three technological approaches deserve special attention. The first relates to forensic technology, or the detection of forgeries through technical means.Just as researchers are putting a great deal of time and effort into creating credible fakes, so, too, are they developing methods of enhanced detection. In June 2018, computer scientists at Dartmouth and the University at Albany, SUNY, announced that they had created a program that detects deepfakes by looking for abnormal patterns of eyelid movement when the subject of a video blinks. In the deepfakes arms race, however, such advances serve only to inform the next wave of innovation. In the future, GANS will be fed training videos that include examples of normal blinking. And even if extremely capable detection algorithms emerge, the speed with which deepfakes can circulate on social media will make debunking them an uphill battle. By the time the forensic alarm bell rings, the damage may already be done.

A second technological remedy involves authenticating content before it ever spreads—an approach sometimes referred to as a “digital provenance” solution. Companies such as Truepic are developing ways to digitally watermark audio, photo, and video content at the moment of its creation, using meta data that can be logged immutably on a distributed ledger, or blockchain. In other words, one could effectively stamp content with a record of authenticity that could be used later as a reference to compare to suspected fakes.

In theory, digital provenance solutions are an ideal fix. In practice, they face two big obstacles. First, they would need to be ubiquitously deployed in the vast array of devices that capture content, including laptops and smartphones. Second, their use would need to be made a precondition for uploading content to the most popular digital platforms, such as Facebook, Twitter, and YouTube. Neither condition is likely to be met. Device makers, absent some legal or regulatory obligation, will not adopt digital authentication until they know it is affordable, in demand, and unlikely to interfere with the performance of their products. And few social media platforms will want to block people from uploading unauthenticated content, especially when the first one to do so will risk losing market share to less rigorous competitors.

A third, more speculative technological approach involves what has been called “authenticated alibi services,” which might soon begin emerging from the private sector. Consider that deepfakes are especially dangerous to high-profile individuals, such as politicians and celebrities, with valuable but fragile reputations. To protect themselves against deepfakes, some of these individuals may choose to engage in enhanced forms of “lifelogging”—the practice of recording nearly every aspect of one’s life—in order to prove where they were and what they were saying or doing at any given time. Companies might begin offering bundles of alibi services, including wearables to make lifelogging convenient, storage to cope with the vast amount of resulting data, and credible authentication of those data. These bundles could even include partnerships with major news and social media platforms, which would enable rapid confirmation or debunking of content.

Such logging would be deeply invasive, and many people would want nothing to do with it. But in addition to the high-profile individuals who choose to adopt lifelogging to protect themselves, some employers might begin insisting on it for certain categories of employees, much as police departments increasingly require officers to use body cameras. And even if only a relatively small number of people took up intensive lifelogging, they would produce vast repositories of data in which the rest of us would find ourselves inadvertently caught, creating a massive peer-to-peer surveillance network for constantly recording our activities.

LAYING DOWN THE LAW

张开法网

If these technological fixes have limited upsides, what about legal remedies? Depending on the circumstances, making or sharing a deepfake could constitute defamation, fraud, or misappropriation of a person’s likeness, among other civil and criminal violations. In theory, one could close any remaining gaps by criminalizing (or attaching civil liability to) specific acts—for instance, creating a deepfake of a real person with the intent to deceive a viewer or listener and with the expectation that this deception would cause some specific kind of harm. But it could be hard to make these claims or charges stick in practice. To begin with, it will likely prove very difficult to attribute the creation of a deepfake to a particular person or group. And even if perpetrators are identified, they may be beyond a court’s reach, as in the case of foreign individuals or governments.

Another legal solution could involve incentivizing social media platforms to do more to identify and remove deepfakes or fraudulent content more generally. Under current U.S. law, the companies that own these platforms are largely immune from liability for the content they host, thanks to Section 230 of the Communications Decency Act of 1996. Congress could modify this immunity, perhaps by amending Section 230 to make companies liable for harmful and fraudulent information distributed through their platforms unless they have made reasonable efforts to detect and remove it. Other countries have used a similar approach for a different problem: in 2017, for instance, Germany passed a law imposing stiff fines on social media companies that failed to remove racist or threatening content within 24 hours of it being reported.

Yet this approach would bring challenges of its own. Most notably, it could lead to excessive censorship. Companies anxious to avoid legal liability would likely err on the side of policing content too aggressively, and users themselves might begin to self-censor in order to avoid the risk of having their content suppressed. It is far from obvious that the notional benefits of improved fraud protection would justify these costs to free expression. Such a system would also run the risk of insulating incumbent platforms, which have the resources to police content and pay for legal battles, against competition from smaller firms.

LIVING WITH LIES

与虚假为伴

But although deepfakes are dangerous, they will not necessarily be disastrous. Detection will improve, prosecutors and plaintiffs will occasionally win legal victories against the creators of harmful fakes, and the major social media platforms will gradually get better at flagging and removing fraudulent content. And digital provenance solutions could, if widely adopted, provide a more durable fix at some point in the future.

In the meantime, democratic societies will have to learn resilience. On the one hand, this will mean accepting that audio and video content cannot be taken at face value; on the other, it will mean fighting the descent into a post-truth world, in which citizens retreat to their private information bubbles and regard as fact only that which flatters their own beliefs. In short, democracies will have to accept an uncomfortable truth: in order to survive the threat of deepfakes, they are going to have to learn how to live with lies.

来源:微信公众号“我与我们的世界”

编辑:马晓晴

作者: 刘海明 时间: 2019-1-20 11:55

提示: 该帖被管理员或版主屏蔽

作者: admin 时间: 2019-1-20 15:48

【案例】

喻国明等:新闻人的价值位移与人机协同的未来趋势

人工智能技术在新闻传播领域的全面渗透是近年来的一个现象级的发展,其中,机器新闻写作是人工智能在传媒领域的具体应用之一。有研究表明,未来传媒业的发展,很大程度上与人工智能技术的引入和应用关联在一起。人工智能技术不仅形塑着整个传媒业的业态面貌,也在微观上重塑着传媒产业的业务链。本文试图分析人工智能技术下机器新闻写作的应用及其升级换代对于机器新闻写作对于新闻生产模式的再造效应,并探讨在此背景下新闻人的价值位移与人机协同的未来趋势,以期为人们把握人工智能如何改变未来传媒业的范式和逻辑方面提供一些参照性的依据。

一、web3.0的关键词是“智能化”,机器新闻写作便是人工智能与传媒业联姻的产物,它将内容生产范式从媒体精英式的内容产出和用户生产内容转换到算法生成内容。这一改变影响深刻而重大。

纵观传媒业的发展进程,技术一直是驱动其变革的重要力量。每一次重要技术的引进,都在某种程度上引发了新闻生产和传播流程的改变,有时甚至会对整个传媒格局产生颠覆性的影响。从这个意义上讲,传媒业中从来就没有永恒的赢家。在技术“喜新厌旧”本性的作用下,今日的新媒体转眼就可能成为“明日黄花”;新闻记者今天所掌握的某种新技能,明天就可能变得无用武之地——整个传媒行业在残酷的“破”与“立”之间寻找着动态的平衡。如果说web1.0和web2.0的关键词分别是“网络化”和“数字化”,那么web3.0的关键词就是“智能化”。它与传媒业的耦合,催生了机器新闻写作,并将内容生产范式从媒体精英式的内容产出和用户生产内容转换到算法生成内容。这种技术上的革新必然会对现在的传媒生态产生影响,首当其冲的便是与其在目标任务上具有极高重合度的新闻记者。

1. 写稿机器人的不断涌现以及升级换代,势必导致传媒业深层次的重组,机器新闻写作正在“蚕食”传统新闻记者的职业领地。

事实上,这种冲击已经不再是一种单纯的想象或理论逻辑上的推演,而是实实在在、正在发生的事实。在西方传媒界,机器新闻写作自2006年首次被引入以来,已经在体育报道、财经报道、气象报道等诸多领域得到较为普遍的应用,并逐渐形成规模化的趋势。包括《纽约时报》《华盛顿邮报》《洛杉矶时报》《卫报》等在内的知名媒体纷纷将机器人纳入批量化的日常新闻写作的流程之中;美联社更是在机器写作之外,启用编辑机器人对机器自动生成的稿件进行审查,成为第一家全面引入机器新闻人的传媒机构。在中国,机器新闻写作虽然起步较晚,但其也已在传统媒体和新媒体“双平台发力”。从腾讯财经的Dreamwriter到新华社的“快笔小新”再到今日头条的“张小明”,这些写稿机器人的不断涌现以及升级换代,无不暗示着传媒业深层次地改变:机器新闻写作正在侵蚀传统新闻记者的职业领域,它正在传媒市场上“攻城略地”。

2. 机器新闻写作高效、全天候的工作模式使它在生产出海量新闻稿的同时,在突发事件的报道中发挥着越来越重要的作用

机器新闻写作拥有传统新闻记者无可比拟的优势,高效是其最大的特色,而这无疑契合了高速运转的现代社会对新闻时效性越来越迫切的需求。机器新闻写作遵循“抓取数据-分析数据-套用模板-生成稿件-人工把关”这一模式化的生产流程,可以在几秒甚至几毫秒内生产出一篇新闻报道。它还能做到一天24小时、一周7天的无间歇性运作。众所周知,突发事件是彰显传媒影响力的竞争高地,机器新闻写作这种高效、全天候的工作模式使它在生产出海量新闻稿之余,也在深具影响力的突发事件的报道中发挥着越来越重要的作用。例如,在地震灾难发生时,机器可以在相关数据库中第一时间采集到地震数据,并生成新闻稿进行报道。新闻生产在通往“事件发生-媒体报道”无缝对接的道路上,又向前迈进了一大步。这些都无疑将使机器新闻写作在未来新闻报道中扮演越来越重要的角色。

3.机器新闻写作长于枯燥的、海量数据的资料处理,在整体性、精确性和高效能方面具有独特优势。

机器新闻写作能最大限度地保障新闻的真实性,尤其是在数据型、模式化的新闻生产中更是如此。它长于处理在人类看来琐碎、庞杂的数据信息,通过既定程序对既定算法的实现,可以保证生成文本在新闻要素、新闻事实、引用数据等方面得完整和准确。除非程序设置出现偏差或者存在人为刻意地干预,否则这种数据信息的文本化呈现,在精准度上要远高于新闻记者,避免了人工录入可能出现的失误。借助大数据平台,机器新闻写作能对同一新闻事件的数据来源、内容细节进行多角度的反复对比,在“相互比对、相互印证”中,让事实真相越辩越明,让虚假信息无处容身,从而实现新闻信息的去伪存真。

4. 机器新闻写作不仅能够生产用户偏好的新闻内容或新闻风格,而且还能提供与用户的个人生活场景相匹配的私人定制产品。

机器新闻写作还能实现个性化的内容定制,这是传统新闻记者所无法承担和胜任的。众所周知,传统新闻生产是以最大多数人共性的信息需求为基础的,个人个性化的需求在很大程度上被忽略了。机器新闻写作的一个优势在于,它在报道热门新闻事件的同时,能够对几乎同步发生的、相对冷门的新闻事件进行报道,从而使新闻需求的长尾效应得以激活和放大。例如,今日头条的写稿机器人“张小明”在里约奥运会期间,对上百场赛事都进行了报道。事实证明,那些看似很冷门、受众关注度不高的体育报道,依然得到了相当可观的阅读量,小众的个性化阅读需求得到满足。随着技术的革新、人们对机器新闻写作群智式的修正与完善以及机器本身对语料库的不断学习,机器新闻写作会变得越来越“类人化”。 它能够针对同一新闻事件生产出风格迥异的内容版本,以适配不同受众的需求。而当技术发展到足够成熟,物与物能够互联、互通乃至“万物皆媒”时,机器新闻写作所提供给个人的将不再仅仅是其喜欢的新闻内容或偏好的新闻风格,纳入其中的,还有与其个人相匹配的生活场景——这将会是一种全方位的私人定制。

5.在机器新闻写作逐步升级换代的大背景下,只会对新闻素材剪贴拼接的媒体工作者必将被逐出新闻传播的专业岗位。

在这些优势的裹挟之下,机器新闻写作或将在两个维度对新闻记者产生深层次的影响:一是“谁来写”,二是“写什么”。一直以来,新闻写作都被视为是人类所独有的创造性活动,是实现社会成员间信息共享、价值传播,进而建构社会共同体的重要手段。新闻记者以“我在现场,我来告诉你发生了什么”的方式,树立了自己在新闻生产中的核心地位,并激发了人们对新闻报道背后的新闻记者的人格化想象。互联网颠覆了既有的传媒格局,这种颠覆,作用于新闻记者产生的一个重大变化,就是新闻生产与采访的日渐脱节。很多从事消息类写作等规格化内容生产的记者,不再依赖于现场采访,而是通过轻点鼠标,获取所需的新闻信息。这种信息获取的方式固然有其可取之处,但倘若新闻记者满足于此,将采访这一看家本领从自身剥离开,那么新闻记者在新闻生产中的地位将会被进一步弱化。机器新闻写作的出现,使这一担忧变成了现实。因为它不仅“能写”,打破了“人是新闻生产的唯一主体”这一既定认知,将人从写作的神坛上拉了下来,而且“会写”,甚至在特定的新闻范式内,写的比人更出色。当机器可以更快、更好、更廉价地从事新闻生产时,在市场逐利性的作用下,相当一部分不依赖于自己生产原创内容而只会在网络上拼拼贴贴,或者只能从事较低端写作的新闻记者一定会被从新闻市场中驱逐出去。这一幕,在过去数十年间,机器对蓝领工人大浪淘沙式地筛选中已经上演。

6.机器新闻写作的算法模型将深刻地影响着我们对于世界的理解与思考模式

媒介环境学派代表人物麦克卢汉曾提出“媒介即讯息”的观点。他精辟地指出,“人类只有在拥有了某种媒介之后,才有可能从事与之相适应的传播和其他社会活动。媒介最重要的作用就是影响了我们理解和思考的习惯”。当机器新闻写作作为一种新的媒介手段进入传媒行业时,它就已经开始对新闻记者的认知产生影响,进而在很大程度上左右着新闻记者“写什么”。这种影响主要经由两条路径来实现:一是机器新闻写作能够捕捉到某一时段受众关注的焦点,并定位数据、搜集素材,为新闻记者的写作提供方向;二是机器新闻写作能够对数据进行结构化地呈现与分析,从而将那些单看起来可能意义不大、但连接起来又很有意义的信息挖掘出来。这种形式的信息呈现无疑具有一种更加宏观的视角,更加符合互联网“连接产生意义”的本质。它将新闻记者受限于主客观条件地制约而忽略或者压根没有意识到的信息与信息间的内在关联,从碎片化的海量信息中寻找出来,为新闻记者提供了看待问题的全新视角。因此,从表面看,机器只是为新闻记者筛选素材的一种辅助性工具,新闻记者从这些呈现的素材中寻找思路和灵感,掌控着新闻生产主动权。但实际上,新闻记者看待问题的角度和方式已在这一过程中潜移默化地改变了。

同样的,当机器新闻写作大规模地在传媒领域登堂入室,占据重要地位时,它也必将对于用户的世界观、方法论及把握世事的逻辑产生深刻的影响。总体上它会使人们更加精确、及时和完整地认识世界和把握世界,但这其中算法模型的品质高下将成为未来社会沟通和理解的关键之一。

二、人工智能并非万能:机器新闻写作不是新闻记者的“终结者”,人机协同是未来传媒生产的主流模式

机器新闻写作对新闻记者的冲击和影响现已成为传媒行业的一个基本共识。特别是随着技术的指数级发展,这种冲击会变得愈发强烈。新闻记者应有危机意识,正视现实、积极应对,但也不应太过悲观,沉浸于新闻记者的末日想象中无法自拔。机器新闻写作并不能成为新闻记者的“终结者”。

1.算法、模板是机器新闻写作永远跳不出去的“窠臼”,超越算法和模板是机器新闻写作所不能的。不仅如此,当公开的信息呈现不足时、当需要透过错综复杂的社会关系进行价值判断时,机器新闻写作都暴露出自己的“阿基里斯脚踵”。

机器新闻写作受限于技术规则的影响,存有自身的局限性。与人类相比,机器最大的软肋在于缺乏人的思辨能力、情感表达能力和创造能力。这就导致机器新闻写作从应用领域看,主要集中于体育赛事、财经报道、突发事件等高数据密度、高信息透明度、低语境的新闻报道中。这类报道往往简单而程式化,属于新闻生产中层次较低的产品。而对于调查报道、新闻评论等信息呈现相对稀缺、需要更多地克服障碍进行挖掘的报道任务;以及对于那些需要在错综复杂的社会关系中做出价值判断的作品,机器新闻写作还鲜有涉猎。从报道内容看,机器新闻写作注重事实而轻视观点,所呈现出的内容往往是简单信息的排列组合,还不具备价值解析和舆论引导的能力,更缺乏深度思考和人文关怀。从报道形式看,机器新闻写作多是对既有模板的套用,属于流水线似的生产,规范却呆板,容易导致人的审美疲劳。受益于技术开发人员对机器新闻写作模式的深度挖掘和对写作模板的扩充与丰富,机器新闻写作的风格会愈发多元。但总体而言,这种多元化的风格依然局限于一定的题材范围内,当所报道的话题超出模板所能覆盖的范围时,机器新闻写作模式化的短板将暴露无遗。

2.技术发展的速度与社会形态、法制规则进化速度的不对称可能引发来自社会政治和法律层面的风险。

机器新闻写作因技术推进和业务倚重,呈现出扩散性发展态势。由于其发展速度与相关规章制度出台之间存有“时差”,导致机器新闻写作不断涌现的诸多新问题、新情况得不到及时、有效地解决,可能面临着来自社会政治和法律层面的风险。机器新闻写作的一个重要基础是对海量数据的挖掘,这些数据有的来自门户类网站,有的来自谷歌、百度等搜索引擎,有的来自以UGC为基础的社会化媒体,有的来自移动终端对私人化信息的采集等。理想状态下,机器新闻写作应该在尽可能大的范围内挖掘数据,通过对海量数据的不断学习,实现自身的越来越智能化。但在现实中,所有数据的采集、利用都存在边界问题。机器可以对哪些数据进行挖掘,不可以对哪些数据进行挖掘,这个界线亟待澄清,否则容易侵犯他人隐私,产生滥用数据的隐忧。机器新闻写作在法律层面的另一个“盲区”,在于新闻产品著作权的保护。例如,机器新闻写作所依托的模板,是相关技术开发人员将文字程序语言转化成计算机编码语言写成的,包含着技术开发人员对特定资料地搜集与取舍。这些模板是否构成作品?经由这些模板生成的稿件是否享有版权?如果享有版权,谁是版权的拥有者?……诸如此类的问题,目前在学界和业界尚有争议,还没有达成共识,很可能成为阻碍机器新闻写作进一步发展的绊脚石。

3.人机协同将成为未来传媒生产的主流模式

机器新闻写作还离不开新闻记者的把关,特别是在重大而敏感的议题上更是如此。虽然目前少数媒体已经采用机器审核的方式,将机器写作完成的稿件直接发布,但多数媒体还是保留了“人工审核”这一关键步骤。这主要是因为机器本身并不具有独立判断新闻倾向和新闻价值的能力,其对材料的筛选更多源于对关键词句等数据的获取。人类写作的复杂之处在于,其可以在完全不出现敏感词的前提下,进行自我价值判断的预设与植入。而这无疑超出了机器所能理解的范畴,需要新闻记者帮忙,将那些不符合群体规范或把关人价值标准的信息剔除掉。例如,机器新闻写作在地震灾难的报道中,可能会抓取到一些血淋淋的现场图片。这些照片固然是真实的,可以反映彼时现场的真实面貌,但是却并不适合大范围传播。新闻报道在履行告知功能之外,还要考虑到对社会舆论的影响。归根究底,新闻报道应该弘扬真善美,而不应为了满足人的猎奇心理和窥私欲,挑战人的生理与心理极限。

机器新闻写作对新闻记者也并非全无助益。传统新闻记者在写稿时一般遵循“搜集资料-分析资料-整合思路-进行写作”的过程。其中“资料搜集”这一初始阶段往往费时又费力。机器新闻写作能够实现资料得实时、迅速抓取,使新闻记者得以从重复、繁琐、低技术含量的数据搜集工作中解放出来,能够有更多时间去思考和从事更具想象力和创造力的工作。从这一角度而言,机器人记者可以成为新闻记者的好帮手,关键在于如何去合理地运用它。面对机器对新闻行业的冲击,新闻记者不应也不会坐以待毙,求新求变、顺势而为才是上策之选。在机器新闻写作的不断“倒逼”下,新闻记者有望实现职责的转型与升级,入职门槛将大大提高。除了更深厚的人文素养、更娴熟的文字表达技巧、更精湛的视觉呈现能力外,看待问题时是否拥有更大的视野与格局,分析问题时是否拥有强大判断力和深度阐释力,成为检验新闻记者是否具有核心竞争力的关键指标。传统的“消息型”记者将让位于机器新闻写作,调查性新闻、解释性新闻等高品质新闻类型才是新闻记者的主战场。

概言之,机器新闻写作所引领的新的新闻生产的变革已经不可避免,在这波技术浪潮中,如何正确认识人与机器的关系,左右着人们对未来新闻行业发展趋势的判断。事实上,无论机器新闻写作如何发展,人始终都是新闻生产的核心要素,机器只是人的附属,这一点从来都没有改变。未来,人机协同将是传媒业的常态。二者如何协同合作,生产出更多元、更高品质的作品,是机器新闻写作下一步努力的方向。